mirror of

https://github.com/crewAIInc/crewAI.git

synced 2026-01-09 16:18:30 +00:00

Add Korean translations (#3307)

This commit is contained in:

124

docs/ko/observability/agentops.mdx

Normal file

124

docs/ko/observability/agentops.mdx

Normal file

@@ -0,0 +1,124 @@

|

||||

---

|

||||

title: AgentOps 통합

|

||||

description: AgentOps를 사용하여 에이전트 성능을 이해하고 로깅하기

|

||||

icon: paperclip

|

||||

---

|

||||

|

||||

# 소개

|

||||

|

||||

Observability는 대화형 AI 에이전트를 개발하고 배포하는 데 있어 핵심적인 요소입니다. 이는 개발자가 에이전트의 성능을 이해하고, 에이전트가 사용자와 어떻게 상호작용하는지, 그리고 에이전트가 외부 도구와 API를 어떻게 사용하는지를 파악할 수 있게 해줍니다.

|

||||

AgentOps는 CrewAI와 독립적인 제품으로, 에이전트를 위한 종합적인 observability 솔루션을 제공합니다.

|

||||

|

||||

## AgentOps

|

||||

|

||||

[AgentOps](https://agentops.ai/?=crew)은 에이전트에 대한 세션 리플레이, 메트릭, 모니터링을 제공합니다.

|

||||

|

||||

AgentOps는 높은 수준에서 비용, 토큰 사용량, 대기 시간, 에이전트 실패, 세션 전체 통계 등 다양한 항목을 모니터링할 수 있는 기능을 제공합니다.

|

||||

더 자세한 내용은 [AgentOps Repo](https://github.com/AgentOps-AI/agentops)를 확인하세요.

|

||||

|

||||

### 개요

|

||||

|

||||

AgentOps는 개발 및 프로덕션 환경에서 에이전트에 대한 모니터링을 제공합니다.

|

||||

에이전트 성능, 세션 리플레이, 맞춤형 리포팅을 추적할 수 있는 대시보드를 제공합니다.

|

||||

|

||||

또한, AgentOps는 Crew 에이전트 상호작용, LLM 호출, 툴 사용을 실시간으로 볼 수 있는 세션 드릴다운 기능을 제공합니다.

|

||||

이 기능은 에이전트가 사용자 및 다른 에이전트와 어떻게 상호작용하는지 디버깅하고 이해하는 데 유용합니다.

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

### 특징

|

||||

|

||||

- **LLM 비용 관리 및 추적**: 기반 모델 공급자와의 지출을 추적합니다.

|

||||

- **재생 분석**: 단계별 에이전트 실행 그래프를 시청할 수 있습니다.

|

||||

- **재귀적 사고 감지**: 에이전트가 무한 루프에 빠졌는지 식별합니다.

|

||||

- **맞춤형 보고서**: 에이전트 성능에 대한 맞춤형 분석을 생성합니다.

|

||||

- **분석 대시보드**: 개발 및 운영 중인 에이전트에 대한 상위 수준 통계를 모니터링합니다.

|

||||

- **공개 모델 테스트**: 벤치마크 및 리더보드를 통해 에이전트를 테스트할 수 있습니다.

|

||||

- **맞춤형 테스트**: 도메인별 테스트로 에이전트를 실행합니다.

|

||||

- **타임 트래블 디버깅**: 체크포인트에서 세션을 재시작합니다.

|

||||

- **컴플라이언스 및 보안**: 감사 로그를 생성하고 욕설 및 PII 유출과 같은 잠재적 위협을 감지합니다.

|

||||

- **프롬프트 인젝션 감지**: 잠재적 코드 인젝션 및 시크릿 유출을 식별합니다.

|

||||

|

||||

### AgentOps 사용하기

|

||||

|

||||

<Steps>

|

||||

<Step title="API 키 생성">

|

||||

사용자 API 키를 여기서 생성하세요: [API 키 생성](https://app.agentops.ai/account)

|

||||

</Step>

|

||||

<Step title="환경 설정">

|

||||

API 키를 환경 변수에 추가하세요:

|

||||

```bash

|

||||

AGENTOPS_API_KEY=<YOUR_AGENTOPS_API_KEY>

|

||||

```

|

||||

</Step>

|

||||

<Step title="AgentOps 설치">

|

||||

다음 명령어로 AgentOps를 설치하세요:

|

||||

```bash

|

||||

pip install 'crewai[agentops]'

|

||||

```

|

||||

또는

|

||||

```bash

|

||||

pip install agentops

|

||||

```

|

||||

</Step>

|

||||

<Step title="AgentOps 초기화">

|

||||

스크립트에서 `Crew`를 사용하기 전에 다음 코드를 포함하세요:

|

||||

|

||||

```python

|

||||

import agentops

|

||||

agentops.init()

|

||||

```

|

||||

|

||||

이렇게 하면 AgentOps 세션이 시작되고 Crew 에이전트가 자동으로 추적됩니다. 더 복잡한 agentic 시스템을 구성하는 방법에 대한 자세한 정보는 [AgentOps 문서](https://docs.agentops.ai) 또는 [Discord](https://discord.gg/j4f3KbeH)를 참조하세요.

|

||||

</Step>

|

||||

</Steps>

|

||||

|

||||

### Crew + AgentOps 예시

|

||||

|

||||

<CardGroup cols={3}>

|

||||

<Card

|

||||

title="Job Posting"

|

||||

color="#F3A78B"

|

||||

href="https://github.com/joaomdmoura/crewAI-examples/tree/main/job-posting"

|

||||

icon="briefcase"

|

||||

iconType="solid"

|

||||

>

|

||||

채용 공고를 생성하는 Crew agent의 예시입니다.

|

||||

</Card>

|

||||

<Card

|

||||

title="Markdown Validator"

|

||||

color="#F3A78B"

|

||||

href="https://github.com/joaomdmoura/crewAI-examples/tree/main/markdown_validator"

|

||||

icon="markdown"

|

||||

iconType="solid"

|

||||

>

|

||||

Markdown 파일을 검증하는 Crew agent의 예시입니다.

|

||||

</Card>

|

||||

<Card

|

||||

title="Instagram Post"

|

||||

color="#F3A78B"

|

||||

href="https://github.com/joaomdmoura/crewAI-examples/tree/main/instagram_post"

|

||||

icon="square-instagram"

|

||||

iconType="brands"

|

||||

>

|

||||

Instagram 게시물을 생성하는 Crew agent의 예시입니다.

|

||||

</Card>

|

||||

</CardGroup>

|

||||

|

||||

### 추가 정보

|

||||

|

||||

시작하려면 [AgentOps 계정](https://agentops.ai/?=crew)을 생성하세요.

|

||||

|

||||

기능 요청이나 버그 보고가 필요하시면 [AgentOps Repo](https://github.com/AgentOps-AI/agentops)에서 AgentOps 팀에 문의해 주세요.

|

||||

|

||||

#### 추가 링크

|

||||

|

||||

<a href="https://twitter.com/agentopsai/">🐦 트위터</a>

|

||||

<span> • </span>

|

||||

<a href="https://discord.gg/JHPt4C7r">📢 디스코드</a>

|

||||

<span> • </span>

|

||||

<a href="https://app.agentops.ai/?=crew">🖇️ AgentOps 대시보드</a>

|

||||

<span> • </span>

|

||||

<a href="https://docs.agentops.ai/introduction">📙 문서화</a>

|

||||

149

docs/ko/observability/arize-phoenix.mdx

Normal file

149

docs/ko/observability/arize-phoenix.mdx

Normal file

@@ -0,0 +1,149 @@

|

||||

---

|

||||

title: Arize Phoenix

|

||||

description: OpenTelemetry 및 OpenInference가 포함된 CrewAI용 Arize Phoenix 통합

|

||||

icon: magnifying-glass-chart

|

||||

---

|

||||

|

||||

# Arize Phoenix 통합

|

||||

|

||||

이 가이드는 [OpenInference](https://github.com/openinference/openinference) SDK를 통해 OpenTelemetry를 사용하여 **Arize Phoenix**를 **CrewAI**와 통합하는 방법을 보여줍니다. 이 가이드를 완료하면 CrewAI agent를 추적하고 agent를 쉽게 디버그할 수 있습니다.

|

||||

|

||||

> **Arize Phoenix란?** [Arize Phoenix](https://phoenix.arize.com)는 AI 애플리케이션을 위한 추적 및 평가 기능을 제공하는 LLM 가시성(observability) 플랫폼입니다.

|

||||

|

||||

[](https://www.youtube.com/watch?v=Yc5q3l6F7Ww)

|

||||

|

||||

## 시작하기

|

||||

|

||||

CrewAI를 사용하고 OpenInference를 통해 OpenTelemetry와 Arize Phoenix를 연동하는 간단한 예제를 단계별로 안내합니다.

|

||||

|

||||

이 가이드는 [Google Colab](https://colab.research.google.com/github/Arize-ai/phoenix/blob/main/tutorials/tracing/crewai_tracing_tutorial.ipynb)에서도 확인하실 수 있습니다.

|

||||

|

||||

### 1단계: 의존성 설치

|

||||

|

||||

```bash

|

||||

pip install openinference-instrumentation-crewai crewai crewai-tools arize-phoenix-otel

|

||||

```

|

||||

|

||||

### 2단계: 환경 변수 설정

|

||||

|

||||

Phoenix Cloud API 키를 설정하고 OpenTelemetry를 구성하여 추적 정보를 Phoenix로 전송합니다. Phoenix Cloud는 Arize Phoenix의 호스팅 버전이지만, 이 통합을 사용하는 데 필수는 아닙니다.

|

||||

|

||||

무료 Serper API 키는 [여기](https://serper.dev/)에서 받을 수 있습니다.

|

||||

|

||||

```python

|

||||

import os

|

||||

from getpass import getpass

|

||||

|

||||

# Get your Phoenix Cloud credentials

|

||||

PHOENIX_API_KEY = getpass("🔑 Enter your Phoenix Cloud API Key: ")

|

||||

|

||||

# Get API keys for services

|

||||

OPENAI_API_KEY = getpass("🔑 Enter your OpenAI API key: ")

|

||||

SERPER_API_KEY = getpass("🔑 Enter your Serper API key: ")

|

||||

|

||||

# Set environment variables

|

||||

os.environ["PHOENIX_CLIENT_HEADERS"] = f"api_key={PHOENIX_API_KEY}"

|

||||

os.environ["PHOENIX_COLLECTOR_ENDPOINT"] = "https://app.phoenix.arize.com" # Phoenix Cloud, change this to your own endpoint if you are using a self-hosted instance

|

||||

os.environ["OPENAI_API_KEY"] = OPENAI_API_KEY

|

||||

os.environ["SERPER_API_KEY"] = SERPER_API_KEY

|

||||

```

|

||||

|

||||

### 3단계: Phoenix와 함께 OpenTelemetry 초기화하기

|

||||

|

||||

OpenInference OpenTelemetry 계측 SDK를 초기화하여 트레이스를 수집하고 Phoenix로 전송합니다.

|

||||

|

||||

```python

|

||||

from phoenix.otel import register

|

||||

|

||||

tracer_provider = register(

|

||||

project_name="crewai-tracing-demo",

|

||||

auto_instrument=True,

|

||||

)

|

||||

```

|

||||

|

||||

### 4단계: CrewAI 애플리케이션 생성하기

|

||||

|

||||

두 명의 에이전트가 협력하여 AI 발전에 관한 블로그 글을 조사하고 작성하는 CrewAI 애플리케이션을 만들어 보겠습니다.

|

||||

|

||||

```python

|

||||

from crewai import Agent, Crew, Process, Task

|

||||

from crewai_tools import SerperDevTool

|

||||

from openinference.instrumentation.crewai import CrewAIInstrumentor

|

||||

from phoenix.otel import register

|

||||

|

||||

# crew에 대한 모니터링 설정

|

||||

tracer_provider = register(

|

||||

endpoint="http://localhost:6006/v1/traces")

|

||||

CrewAIInstrumentor().instrument(skip_dep_check=True, tracer_provider=tracer_provider)

|

||||

search_tool = SerperDevTool()

|

||||

|

||||

# 역할과 목표가 설정된 에이전트 정의

|

||||

researcher = Agent(

|

||||

role="Senior Research Analyst",

|

||||

goal="AI 및 데이터 과학의 최첨단 발전 사항 발견",

|

||||

backstory="""당신은 최고 수준의 기술 싱크탱크에서 근무합니다.

|

||||

새로운 트렌드를 식별하는 데 전문성이 있습니다.

|

||||

복잡한 데이터를 분석하고 실행 가능한 인사이트로 제시하는 데 뛰어납니다.""",

|

||||

verbose=True,

|

||||

allow_delegation=False,

|

||||

# 원하는 모델을 지정할 수 있는 optional llm 속성을 전달할 수 있습니다.

|

||||

# llm=ChatOpenAI(model_name="gpt-3.5", temperature=0.7),

|

||||

tools=[search_tool],

|

||||

)

|

||||

writer = Agent(

|

||||

role="Tech Content Strategist",

|

||||

goal="기술 발전에 대한 매력적인 콘텐츠 작성",

|

||||

backstory="""당신은 통찰력 있고 흥미로운 기사로 유명한 콘텐츠 전략가입니다.

|

||||

복잡한 개념을 매력적인 스토리로 전환합니다.""",

|

||||

verbose=True,

|

||||

allow_delegation=True,

|

||||

)

|

||||

|

||||

# 에이전트를 위한 task 생성

|

||||

task1 = Task(

|

||||

description="""2024년 AI 분야의 최신 발전 상황에 대한 포괄적인 분석을 수행하세요.

|

||||

주요 트렌드, 획기적 기술, 산업에 미칠 잠재적 영향을 식별하세요.""",

|

||||

expected_output="주요 내용을 불릿 포인트로 정리한 전체 분석 보고서",

|

||||

agent=researcher,

|

||||

)

|

||||

|

||||

task2 = Task(

|

||||

description="""제공된 인사이트를 활용하여

|

||||

가장 중요한 AI 발전 내용을 강조하는 흥미로운 블로그 글을 작성하세요.

|

||||

글은 정보성 있고, 기술에 밝은 독자를 대상으로 하면서 읽기 쉽게 써야 합니다.

|

||||

멋지게 들리도록 쓰되, 복잡한 단어는 피하여 AI처럼 들리지 않게 하세요.""",

|

||||

expected_output="최소 4개의 단락으로 구성된 전체 블로그 글",

|

||||

agent=writer,

|

||||

)

|

||||

|

||||

# 순차 프로세스 방식으로 crew 인스턴스화

|

||||

crew = Crew(

|

||||

agents=[researcher, writer], tasks=[task1, task2], verbose=1, process=Process.sequential

|

||||

)

|

||||

|

||||

# crew에게 작업 시작 지시!

|

||||

result = crew.kickoff()

|

||||

|

||||

print("######################")

|

||||

print(result)

|

||||

```

|

||||

|

||||

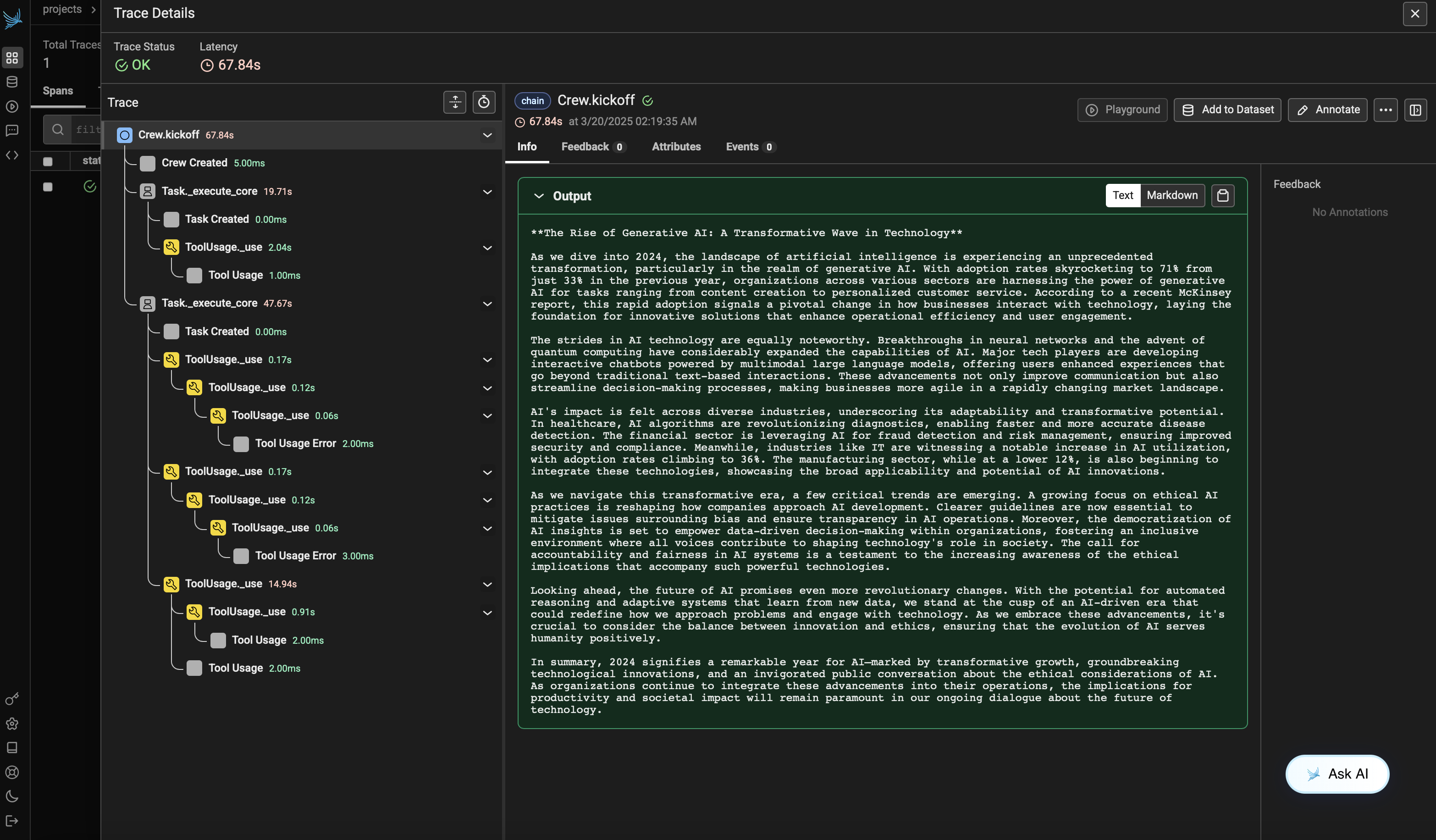

### 5단계: Phoenix에서 트레이스 보기

|

||||

|

||||

에이전트를 실행한 후, Phoenix에서 CrewAI 애플리케이션에 의해 생성된 트레이스를 볼 수 있습니다. 에이전트 상호작용과 LLM 호출의 상세한 단계가 표시되어 AI 에이전트를 디버깅하고 최적화하는 데 도움이 됩니다.

|

||||

|

||||

Phoenix Cloud 계정에 로그인한 다음 `project_name` 파라미터에서 지정한 프로젝트로 이동하세요. 모든 에이전트 상호작용, 도구 사용 및 LLM 호출이 포함된 트레이스의 타임라인 보기를 확인할 수 있습니다.

|

||||

|

||||

|

||||

|

||||

### 버전 호환성 정보

|

||||

- Python 3.8+

|

||||

- CrewAI >= 0.86.0

|

||||

- Arize Phoenix >= 7.0.1

|

||||

- OpenTelemetry SDK >= 1.31.0

|

||||

|

||||

### 참고 자료

|

||||

- [Phoenix 문서](https://docs.arize.com/phoenix/) - Phoenix 플랫폼 개요.

|

||||

- [CrewAI 문서](https://docs.crewai.com/) - CrewAI 프레임워크 개요.

|

||||

- [OpenTelemetry 문서](https://opentelemetry.io/docs/) - OpenTelemetry 가이드

|

||||

- [OpenInference GitHub](https://github.com/openinference/openinference) - OpenInference SDK 소스 코드.

|

||||

284

docs/ko/observability/langdb.mdx

Normal file

284

docs/ko/observability/langdb.mdx

Normal file

@@ -0,0 +1,284 @@

|

||||

---

|

||||

title: LangDB 통합

|

||||

description: LangDB AI Gateway로 CrewAI 워크플로우를 관리, 보안, 최적화하세요—350개 이상의 모델 액세스, 자동 라우팅, 비용 최적화, 완전한 가시성을 제공합니다.

|

||||

icon: database

|

||||

---

|

||||

|

||||

# 소개

|

||||

|

||||

[LangDB AI Gateway](https://langdb.ai)는 여러 대형 언어 모델과의 연결을 지원하는 OpenAI 호환 API를 제공하며, 350개 이상의 언어 모델에 접근할 수 있도록 해주는 관측 플랫폼입니다. 단 한 번의 `init()` 호출로 모든 에이전트 상호작용, 작업 실행 및 LLM 호출이 캡처되어, 애플리케이션을 위한 종합적인 관측성과 프로덕션 수준의 AI 인프라를 제공합니다.

|

||||

|

||||

<Frame caption="LangDB CrewAI 추적 예시">

|

||||

<img src="/images/langdb-1.png" alt="LangDB CrewAI trace example" />

|

||||

</Frame>

|

||||

|

||||

**확인:** [실시간 추적 예시 보기](https://app.langdb.ai/sharing/threads/3becbfed-a1be-ae84-ea3c-4942867a3e22)

|

||||

|

||||

## 기능

|

||||

|

||||

### AI 게이트웨이 기능

|

||||

- **350개 이상의 LLM 접근**: 단일 통합을 통해 모든 주요 언어 모델에 연결

|

||||

- **가상 모델**: 특정 매개변수와 라우팅 규칙으로 맞춤형 모델 구성 생성

|

||||

- **가상 MCP**: 에이전트 간 향상된 통신을 위해 MCP(Model Context Protocol) 시스템과의 호환성 및 통합 지원

|

||||

- **가드레일**: 에이전트 행동에 대한 안전 조치 및 컴플라이언스 제어 구현

|

||||

|

||||

### 가시성 및 추적

|

||||

- **자동 추적**: 단일 `init()` 호출로 모든 CrewAI 상호작용을 캡처

|

||||

- **엔드-투-엔드 가시성**: 에이전트 워크플로우를 시작부터 끝까지 모니터링

|

||||

- **도구 사용 추적**: 에이전트가 사용하는 도구와 그 결과를 추적

|

||||

- **모델 호출 모니터링**: LLM 상호작용에 대한 상세한 인사이트 제공

|

||||

- **성능 분석**: 지연 시간, 토큰 사용량 및 비용 모니터링

|

||||

- **디버깅 지원**: 문제 해결을 위한 단계별 실행

|

||||

- **실시간 모니터링**: 라이브 트레이스 및 메트릭 대시보드

|

||||

|

||||

## 설치 안내

|

||||

|

||||

<Steps>

|

||||

<Step title="LangDB 설치">

|

||||

CrewAI 기능 플래그와 함께 LangDB 클라이언트를 설치하세요:

|

||||

```bash

|

||||

pip install 'pylangdb[crewai]'

|

||||

```

|

||||

</Step>

|

||||

<Step title="환경 변수 설정">

|

||||

LangDB 자격 증명을 구성하세요:

|

||||

```bash

|

||||

export LANGDB_API_KEY="<your_langdb_api_key>"

|

||||

export LANGDB_PROJECT_ID="<your_langdb_project_id>"

|

||||

export LANGDB_API_BASE_URL='https://api.us-east-1.langdb.ai'

|

||||

```

|

||||

</Step>

|

||||

<Step title="추적(Tracing) 초기화">

|

||||

CrewAI 코드를 설정하기 전에 LangDB를 임포트하고 초기화하세요:

|

||||

```python

|

||||

from pylangdb.crewai import init

|

||||

# Initialize LangDB

|

||||

init()

|

||||

```

|

||||

</Step>

|

||||

<Step title="CrewAI와 LangDB 연동 설정">

|

||||

LangDB 헤더와 함께 LLM을 설정하세요:

|

||||

```python

|

||||

from crewai import Agent, Task, Crew, LLM

|

||||

import os

|

||||

|

||||

# Configure LLM with LangDB headers

|

||||

llm = LLM(

|

||||

model="openai/gpt-4o", # Replace with the model you want to use

|

||||

api_key=os.getenv("LANGDB_API_KEY"),

|

||||

base_url=os.getenv("LANGDB_API_BASE_URL"),

|

||||

extra_headers={"x-project-id": os.getenv("LANGDB_PROJECT_ID")}

|

||||

)

|

||||

```

|

||||

</Step>

|

||||

</Steps>

|

||||

|

||||

## 빠른 시작 예제

|

||||

|

||||

여기 LangDB와 CrewAI를 시작하는 간단한 예제가 있습니다:

|

||||

|

||||

```python

|

||||

import os

|

||||

from pylangdb.crewai import init

|

||||

from crewai import Agent, Task, Crew, LLM

|

||||

|

||||

# Initialize LangDB before any CrewAI imports

|

||||

init()

|

||||

|

||||

def create_llm(model):

|

||||

return LLM(

|

||||

model=model,

|

||||

api_key=os.environ.get("LANGDB_API_KEY"),

|

||||

base_url=os.environ.get("LANGDB_API_BASE_URL"),

|

||||

extra_headers={"x-project-id": os.environ.get("LANGDB_PROJECT_ID")}

|

||||

)

|

||||

|

||||

# Define your agent

|

||||

researcher = Agent(

|

||||

role="Research Specialist",

|

||||

goal="Research topics thoroughly",

|

||||

backstory="Expert researcher with skills in finding information",

|

||||

llm=create_llm("openai/gpt-4o"), # Replace with the model you want to use

|

||||

verbose=True

|

||||

)

|

||||

|

||||

# Create a task

|

||||

task = Task(

|

||||

description="Research the given topic and provide a comprehensive summary",

|

||||

agent=researcher,

|

||||

expected_output="Detailed research summary with key findings"

|

||||

)

|

||||

|

||||

# Create and run the crew

|

||||

crew = Crew(agents=[researcher], tasks=[task])

|

||||

result = crew.kickoff()

|

||||

print(result)

|

||||

```

|

||||

|

||||

## 완성된 예제: Research and Planning Agent

|

||||

|

||||

이 포괄적인 예제는 연구 및 기획 기능을 갖춘 multi-agent 워크플로우를 보여줍니다.

|

||||

|

||||

### 사전 준비 사항

|

||||

|

||||

```bash

|

||||

pip install crewai 'pylangdb[crewai]' crewai_tools setuptools python-dotenv

|

||||

```

|

||||

|

||||

### 환경 설정

|

||||

|

||||

```bash

|

||||

# LangDB credentials

|

||||

export LANGDB_API_KEY="<your_langdb_api_key>"

|

||||

export LANGDB_PROJECT_ID="<your_langdb_project_id>"

|

||||

export LANGDB_API_BASE_URL='https://api.us-east-1.langdb.ai'

|

||||

|

||||

# Additional API keys (optional)

|

||||

export SERPER_API_KEY="<your_serper_api_key>" # For web search capabilities

|

||||

```

|

||||

|

||||

### 전체 구현

|

||||

|

||||

```python

|

||||

#!/usr/bin/env python3

|

||||

|

||||

import os

|

||||

import sys

|

||||

from pylangdb.crewai import init

|

||||

init() # Initialize LangDB before any CrewAI imports

|

||||

from dotenv import load_dotenv

|

||||

from crewai import Agent, Task, Crew, Process, LLM

|

||||

from crewai_tools import SerperDevTool

|

||||

|

||||

load_dotenv()

|

||||

|

||||

def create_llm(model):

|

||||

return LLM(

|

||||

model=model,

|

||||

api_key=os.environ.get("LANGDB_API_KEY"),

|

||||

base_url=os.environ.get("LANGDB_API_BASE_URL"),

|

||||

extra_headers={"x-project-id": os.environ.get("LANGDB_PROJECT_ID")}

|

||||

)

|

||||

|

||||

class ResearchPlanningCrew:

|

||||

def researcher(self) -> Agent:

|

||||

return Agent(

|

||||

role="Research Specialist",

|

||||

goal="Research topics thoroughly and compile comprehensive information",

|

||||

backstory="Expert researcher with skills in finding and analyzing information from various sources",

|

||||

tools=[SerperDevTool()],

|

||||

llm=create_llm("openai/gpt-4o"),

|

||||

verbose=True

|

||||

)

|

||||

|

||||

def planner(self) -> Agent:

|

||||

return Agent(

|

||||

role="Strategic Planner",

|

||||

goal="Create actionable plans based on research findings",

|

||||

backstory="Strategic planner who breaks down complex challenges into executable plans",

|

||||

reasoning=True,

|

||||

max_reasoning_attempts=3,

|

||||

llm=create_llm("openai/anthropic/claude-3.7-sonnet"),

|

||||

verbose=True

|

||||

)

|

||||

|

||||

def research_task(self) -> Task:

|

||||

return Task(

|

||||

description="Research the topic thoroughly and compile comprehensive information",

|

||||

agent=self.researcher(),

|

||||

expected_output="Comprehensive research report with key findings and insights"

|

||||

)

|

||||

|

||||

def planning_task(self) -> Task:

|

||||

return Task(

|

||||

description="Create a strategic plan based on the research findings",

|

||||

agent=self.planner(),

|

||||

expected_output="Strategic execution plan with phases, goals, and actionable steps",

|

||||

context=[self.research_task()]

|

||||

)

|

||||

|

||||

def crew(self) -> Crew:

|

||||

return Crew(

|

||||

agents=[self.researcher(), self.planner()],

|

||||

tasks=[self.research_task(), self.planning_task()],

|

||||

verbose=True,

|

||||

process=Process.sequential

|

||||

)

|

||||

|

||||

def main():

|

||||

topic = sys.argv[1] if len(sys.argv) > 1 else "Artificial Intelligence in Healthcare"

|

||||

|

||||

crew_instance = ResearchPlanningCrew()

|

||||

|

||||

# Update task descriptions with the specific topic

|

||||

crew_instance.research_task().description = f"Research {topic} thoroughly and compile comprehensive information"

|

||||

crew_instance.planning_task().description = f"Create a strategic plan for {topic} based on the research findings"

|

||||

|

||||

result = crew_instance.crew().kickoff()

|

||||

print(result)

|

||||

|

||||

if __name__ == "__main__":

|

||||

main()

|

||||

```

|

||||

|

||||

### 예제 실행하기

|

||||

|

||||

```bash

|

||||

python main.py "Sustainable Energy Solutions"

|

||||

```

|

||||

|

||||

## LangDB에서 트레이스 보기

|

||||

|

||||

CrewAI 애플리케이션을 실행한 후, LangDB 대시보드에서 자세한 트레이스를 확인할 수 있습니다:

|

||||

|

||||

<Frame caption="LangDB 트레이스 대시보드">

|

||||

<img src="/images/langdb-2.png" alt="LangDB 트레이스 대시보드에서 CrewAI 워크플로우 표시" />

|

||||

</Frame>

|

||||

|

||||

### 볼 수 있는 내용

|

||||

|

||||

- **에이전트 상호작용**: 에이전트 대화 및 작업 인계의 전체 흐름

|

||||

- **도구 사용**: 호출된 도구, 입력값 및 출력값

|

||||

- **모델 호출**: 프롬프트 및 응답과 함께하는 상세 LLM 상호작용

|

||||

- **성능 지표**: 지연 시간, 토큰 사용량, 비용 추적

|

||||

- **실행 타임라인**: 전체 워크플로우의 단계별 보기

|

||||

|

||||

## 문제 해결

|

||||

|

||||

### 일반적인 문제

|

||||

|

||||

- **추적이 나타나지 않음**: `init()`이 CrewAI 임포트 이전에 호출되었는지 확인하세요

|

||||

- **인증 오류**: LangDB API 키와 프로젝트 ID를 확인하세요

|

||||

|

||||

## 리소스

|

||||

|

||||

<CardGroup cols={3}>

|

||||

<Card title="LangDB 문서" icon="book" href="https://docs.langdb.ai">

|

||||

공식 LangDB 문서 및 가이드

|

||||

</Card>

|

||||

<Card title="LangDB 가이드" icon="graduation-cap" href="https://docs.langdb.ai/guides">

|

||||

AI 에이전트 구축을 위한 단계별 튜토리얼

|

||||

</Card>

|

||||

<Card title="GitHub 예제" icon="github" href="https://github.com/langdb/langdb-samples/tree/main/examples/crewai" >

|

||||

CrewAI 통합 전체 예제

|

||||

</Card>

|

||||

<Card title="LangDB 대시보드" icon="chart-line" href="https://app.langdb.ai">

|

||||

트레이스 및 분석 액세스

|

||||

</Card>

|

||||

<Card title="모델 카탈로그" icon="list" href="https://app.langdb.ai/models">

|

||||

350개 이상의 사용 가능한 언어 모델 살펴보기

|

||||

</Card>

|

||||

<Card title="엔터프라이즈 기능" icon="building" href="https://docs.langdb.ai/enterprise">

|

||||

셀프 호스팅 옵션 및 엔터프라이즈 기능

|

||||

</Card>

|

||||

</CardGroup>

|

||||

|

||||

## 다음 단계

|

||||

|

||||

이 가이드에서는 LangDB AI Gateway를 CrewAI와 통합하는 기본 사항을 다루었습니다. AI 워크플로우를 더욱 강화하려면 다음을 탐색해보세요:

|

||||

|

||||

- **Virtual Models**: 라우팅 전략을 사용한 맞춤형 모델 구성 만들기

|

||||

- **Guardrails & Safety**: 콘텐츠 필터링 및 컴플라이언스 제어 구현

|

||||

- **Production Deployment**: 폴백, 재시도, 로드 밸런싱 구성

|

||||

|

||||

보다 고급 기능 및 사용 사례에 대해서는 [LangDB Documentation](https://docs.langdb.ai)을 방문하거나, [Model Catalog](https://app.langdb.ai/models)를 탐색하여 사용 가능한 모든 모델을 확인해 보세요.

|

||||

109

docs/ko/observability/langfuse.mdx

Normal file

109

docs/ko/observability/langfuse.mdx

Normal file

@@ -0,0 +1,109 @@

|

||||

---

|

||||

title: Langfuse 통합

|

||||

description: OpenLit을 사용하여 OpenTelemetry를 통해 CrewAI와 Langfuse를 통합하는 방법을 알아보세요

|

||||

icon: vials

|

||||

---

|

||||

|

||||

# Langfuse와 CrewAI 통합하기

|

||||

|

||||

이 노트북은 **OpenLit** SDK를 통해 OpenTelemetry를 사용하여 **Langfuse**를 **CrewAI**와 통합하는 방법을 보여줍니다. 이 노트북을 마치면 Langfuse를 사용해 CrewAI 애플리케이션을 추적하여 가시성과 디버깅을 향상시킬 수 있습니다.

|

||||

|

||||

> **Langfuse란 무엇인가요?** [Langfuse](https://langfuse.com)는 오픈 소스 LLM 엔지니어링 플랫폼입니다. 이는 LLM 애플리케이션을 위한 추적 및 모니터링 기능을 제공하며, 개발자들이 AI 시스템을 디버그, 분석 및 최적화하는 데 도움을 줍니다. Langfuse는 네이티브 통합, OpenTelemetry, API/SDK를 통해 다양한 도구 및 프레임워크와 연동됩니다.

|

||||

|

||||

[](https://langfuse.com/watch-demo)

|

||||

|

||||

## 시작하기

|

||||

|

||||

CrewAI를 사용하고 OpenLit을 통해 OpenTelemetry로 Langfuse와 통합하는 간단한 예제를 함께 살펴보겠습니다.

|

||||

|

||||

### 1단계: 의존성 설치

|

||||

|

||||

```python

|

||||

%pip install langfuse openlit crewai crewai_tools

|

||||

```

|

||||

|

||||

### 2단계: 환경 변수 설정

|

||||

|

||||

Langfuse API 키를 설정하고 OpenTelemetry 내보내기 설정을 구성하여 trace를 Langfuse로 전송합니다. Langfuse OpenTelemetry 엔드포인트 `/api/public/otel` 및 인증과 관련된 자세한 내용은 [Langfuse OpenTelemetry 문서](https://langfuse.com/docs/opentelemetry/get-started)를 참고하십시오.

|

||||

|

||||

|

||||

```python

|

||||

import os

|

||||

|

||||

# 프로젝트에 대한 키를 프로젝트 설정 페이지에서 확인하세요: https://cloud.langfuse.com

|

||||

os.environ["LANGFUSE_PUBLIC_KEY"] = "pk-lf-..."

|

||||

os.environ["LANGFUSE_SECRET_KEY"] = "sk-lf-..."

|

||||

os.environ["LANGFUSE_HOST"] = "https://cloud.langfuse.com" # 🇪🇺 EU 지역

|

||||

# os.environ["LANGFUSE_HOST"] = "https://us.cloud.langfuse.com" # 🇺🇸 US 지역

|

||||

|

||||

|

||||

# OpenAI 키

|

||||

os.environ["OPENAI_API_KEY"] = "sk-proj-..."

|

||||

```

|

||||

환경 변수를 설정하면 이제 Langfuse 클라이언트를 초기화할 수 있습니다. get_client()는 환경 변수에 제공된 자격 증명을 사용하여 Langfuse 클라이언트를 초기화합니다.

|

||||

|

||||

```python

|

||||

from langfuse import get_client

|

||||

|

||||

langfuse = get_client()

|

||||

|

||||

# 연결 확인

|

||||

if langfuse.auth_check():

|

||||

print("Langfuse 클라이언트가 인증되었으며 준비되었습니다!")

|

||||

else:

|

||||

print("인증에 실패했습니다. 자격 증명과 호스트를 확인하세요.")

|

||||

```

|

||||

|

||||

### 3단계: OpenLit 초기화

|

||||

|

||||

OpenLit OpenTelemetry 계측 SDK를 초기화하여 OpenTelemetry 추적을 수집하기 시작합니다.

|

||||

|

||||

```python

|

||||

import openlit

|

||||

|

||||

openlit.init()

|

||||

```

|

||||

|

||||

### 4단계: 간단한 CrewAI 애플리케이션 만들기

|

||||

|

||||

여러 에이전트가 협력하여 사용자의 질문에 답하는 간단한 CrewAI 애플리케이션을 만들어보겠습니다.

|

||||

|

||||

|

||||

```python

|

||||

from crewai import Agent, Task, Crew

|

||||

|

||||

from crewai_tools import (

|

||||

WebsiteSearchTool

|

||||

)

|

||||

|

||||

web_rag_tool = WebsiteSearchTool()

|

||||

|

||||

writer = Agent(

|

||||

role="Writer",

|

||||

goal="You make math engaging and understandable for young children through poetry",

|

||||

backstory="You're an expert in writing haikus but you know nothing of math.",

|

||||

tools=[web_rag_tool],

|

||||

)

|

||||

|

||||

task = Task(description=("What is {multiplication}?"),

|

||||

expected_output=("Compose a haiku that includes the answer."),

|

||||

agent=writer)

|

||||

|

||||

crew = Crew(

|

||||

agents=[writer],

|

||||

tasks=[task],

|

||||

share_crew=False

|

||||

)

|

||||

```

|

||||

|

||||

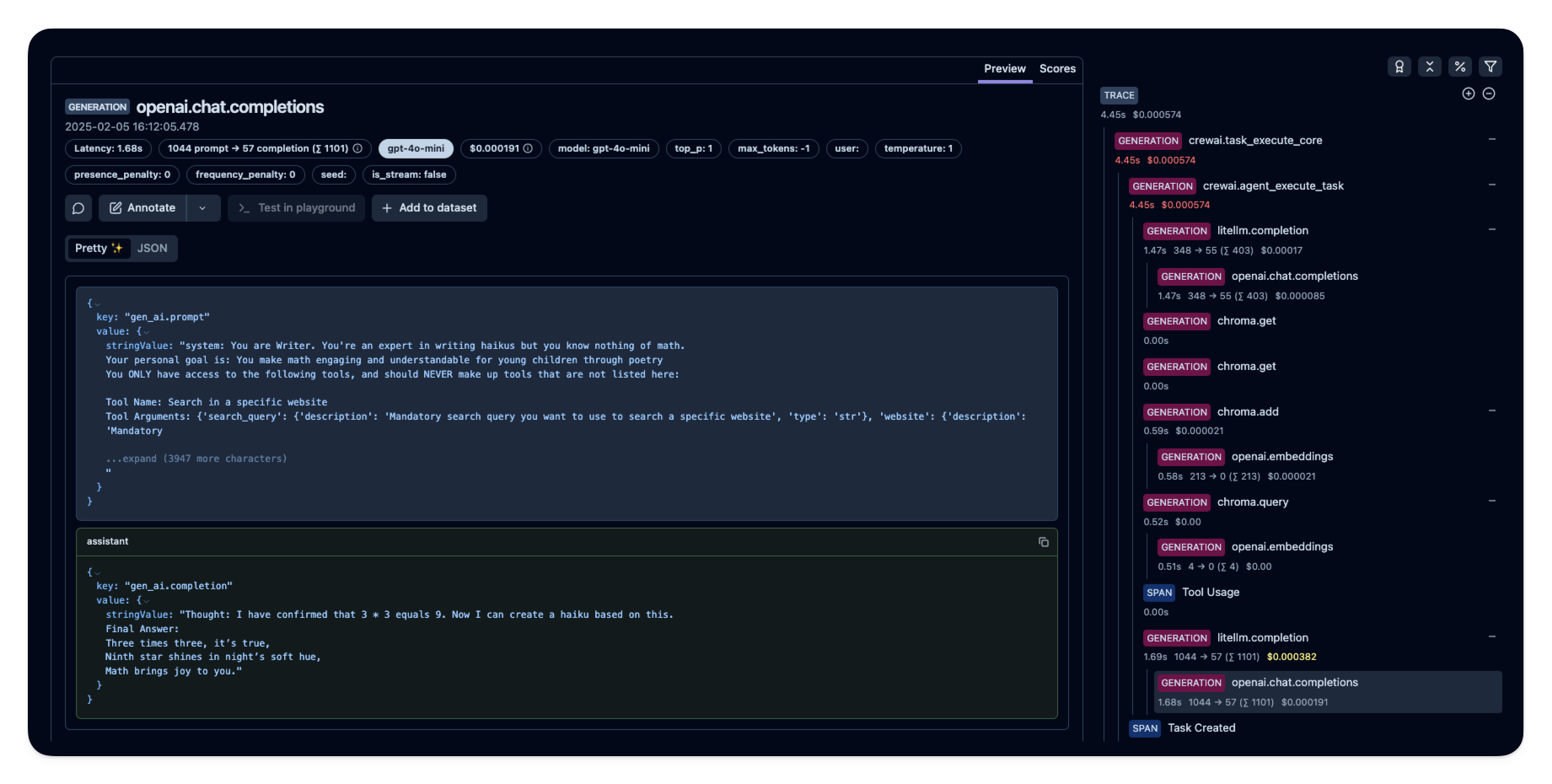

### 5단계: Langfuse에서 트레이스 확인하기

|

||||

|

||||

에이전트를 실행한 후 [Langfuse](https://cloud.langfuse.com)에서 CrewAI 애플리케이션에서 생성된 트레이스를 확인할 수 있습니다. 여기서 LLM 상호작용의 자세한 단계들을 볼 수 있으며, 이를 통해 AI 에이전트의 디버깅 및 최적화에 도움이 됩니다.

|

||||

|

||||

|

||||

|

||||

_[Langfuse의 공개 예시 트레이스](https://cloud.langfuse.com/project/cloramnkj0002jz088vzn1ja4/traces/e2cf380ffc8d47d28da98f136140642b?timestamp=2025-02-05T15%3A12%3A02.717Z&observation=3b32338ee6a5d9af)_

|

||||

|

||||

## 참고 자료

|

||||

|

||||

- [Langfuse OpenTelemetry 문서](https://langfuse.com/docs/opentelemetry/get-started)

|

||||

72

docs/ko/observability/langtrace.mdx

Normal file

72

docs/ko/observability/langtrace.mdx

Normal file

@@ -0,0 +1,72 @@

|

||||

---

|

||||

title: Langtrace 연동

|

||||

description: 외부 가시성 도구인 Langtrace를 사용하여 CrewAI 에이전트의 비용, 지연 시간 및 성능을 모니터링하는 방법.

|

||||

icon: chart-line

|

||||

---

|

||||

|

||||

# Langtrace 개요

|

||||

|

||||

Langtrace는 대형 언어 모델(LLM), LLM 프레임워크, 벡터 데이터베이스에 대한 관측 가능성과 평가를 설정할 수 있도록 도와주는 오픈소스 외부 도구입니다.

|

||||

Langtrace는 CrewAI에 직접 내장되어 있지는 않지만, CrewAI와 함께 사용하여 CrewAI 에이전트의 비용, 지연 시간, 성능에 대해 깊이 있는 가시성을 확보할 수 있습니다.

|

||||

이 통합을 통해 하이퍼파라미터를 기록하고, 성능 회귀를 모니터링하며, 에이전트의 지속적인 개선을 위한 프로세스를 수립할 수 있습니다.

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

## 설정 지침

|

||||

|

||||

<Steps>

|

||||

<Step title="Langtrace에 가입하기">

|

||||

[https://langtrace.ai/signup](https://langtrace.ai/signup)에서 가입하세요.

|

||||

</Step>

|

||||

<Step title="프로젝트 생성">

|

||||

프로젝트 유형을 `CrewAI`로 설정하고 API 키를 생성하세요.

|

||||

</Step>

|

||||

<Step title="CrewAI 프로젝트에 Langtrace 설치하기">

|

||||

다음 명령어를 사용하세요:

|

||||

|

||||

```bash

|

||||

pip install langtrace-python-sdk

|

||||

```

|

||||

</Step>

|

||||

<Step title="Langtrace 임포트하기">

|

||||

스크립트의 시작 부분, CrewAI를 임포트하기 전에 Langtrace를 임포트하고 초기화하세요:

|

||||

|

||||

```python

|

||||

from langtrace_python_sdk import langtrace

|

||||

langtrace.init(api_key='<LANGTRACE_API_KEY>')

|

||||

|

||||

# 이제 CrewAI 모듈을 임포트하세요

|

||||

from crewai import Agent, Task, Crew

|

||||

```

|

||||

</Step>

|

||||

</Steps>

|

||||

|

||||

### 기능 및 CrewAI에의 적용

|

||||

|

||||

1. **LLM 토큰 및 비용 추적**

|

||||

|

||||

- 각 CrewAI 에이전트 상호작용에 대한 토큰 사용량과 관련 비용을 모니터링합니다.

|

||||

|

||||

2. **실행 단계에 대한 추적 그래프**

|

||||

|

||||

- CrewAI 작업의 실행 흐름을 시각화하며, 지연 시간과 로그를 포함합니다.

|

||||

- 에이전트 워크플로우의 병목 지점을 파악하는 데 유용합니다.

|

||||

|

||||

3. **수동 주석을 통한 데이터셋 큐레이션**

|

||||

|

||||

- 미래의 학습 또는 평가를 위해 CrewAI 작업 출력으로부터 데이터셋을 생성합니다.

|

||||

|

||||

4. **프롬프트 버전 관리 및 관리**

|

||||

|

||||

- CrewAI 에이전트에서 사용된 다양한 프롬프트 버전을 추적합니다.

|

||||

- A/B 테스트 및 에이전트 성능 최적화에 유용합니다.

|

||||

|

||||

5. **프롬프트 플레이그라운드 및 모델 비교**

|

||||

|

||||

- 배포 전에 CrewAI 에이전트에 사용할 다양한 프롬프트와 모델을 테스트 및 비교합니다.

|

||||

|

||||

6. **테스트 및 평가**

|

||||

|

||||

- CrewAI 에이전트 및 작업에 대한 자동화된 테스트를 설정합니다.

|

||||

226

docs/ko/observability/maxim.mdx

Normal file

226

docs/ko/observability/maxim.mdx

Normal file

@@ -0,0 +1,226 @@

|

||||

---

|

||||

title: "Maxim Integration"

|

||||

description: "에이전트 모니터링, 평가 및 가시성 시작"

|

||||

icon: "infinity"

|

||||

---

|

||||

|

||||

# Maxim 개요

|

||||

|

||||

Maxim AI는 귀하의 CrewAI 애플리케이션을 위한 포괄적인 에이전트 모니터링, 평가 및 가시성을 제공합니다. Maxim의 원라인 통합을 통해 에이전트 상호작용, 성능 지표 등을 손쉽게 추적하고 분석할 수 있습니다.

|

||||

|

||||

## 특징

|

||||

|

||||

### 프롬프트 관리

|

||||

|

||||

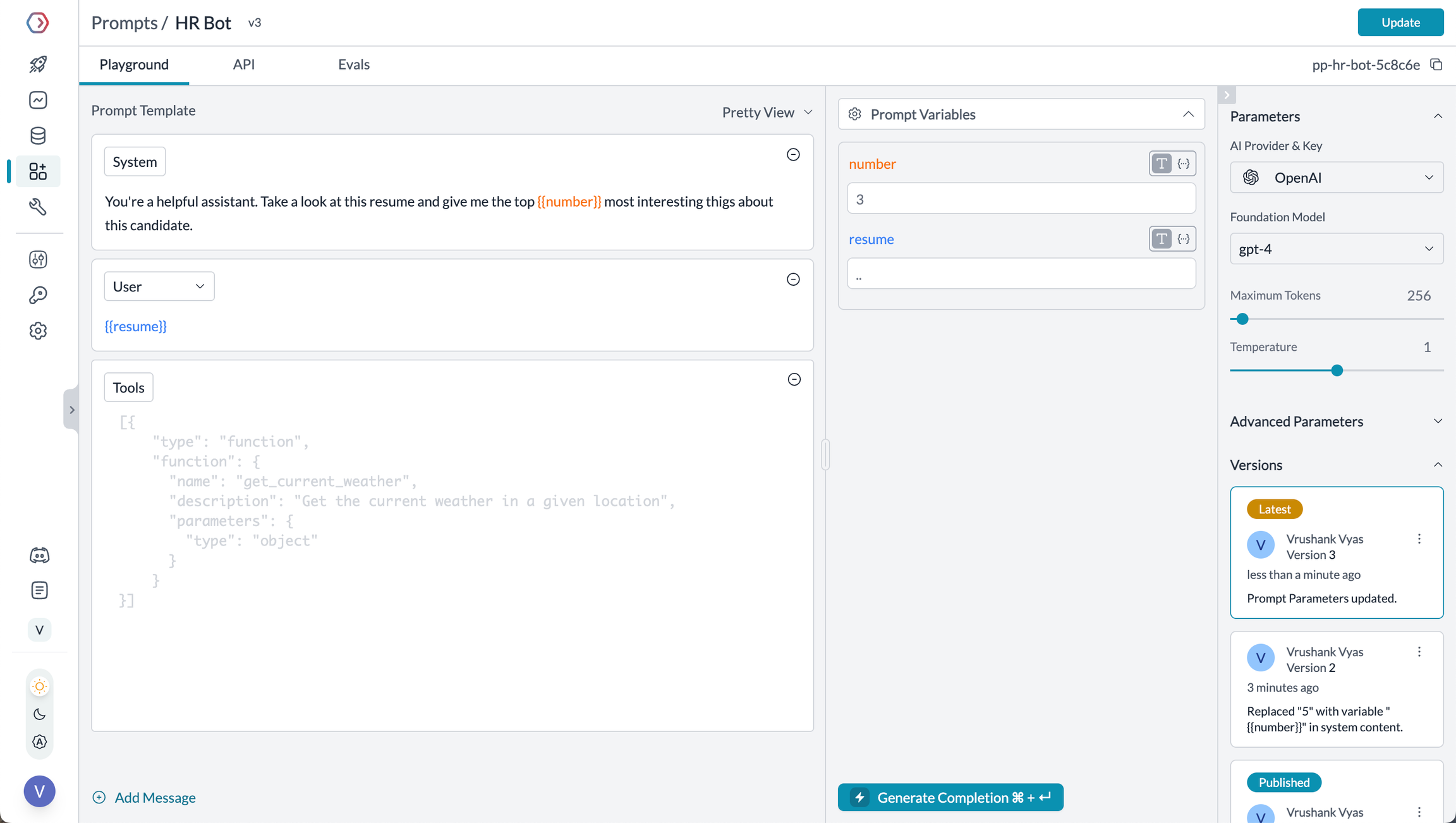

Maxim의 프롬프트 관리 기능을 통해 CrewAI 에이전트를 위한 프롬프트를 생성, 조직, 최적화할 수 있습니다. 지침을 하드코딩하는 대신, Maxim의 SDK를 활용하여 버전 관리가 되는 프롬프트를 동적으로 가져오고 적용하세요.

|

||||

|

||||

<Tabs>

|

||||

<Tab title="프롬프트 플레이그라운드">

|

||||

플레이그라운드를 통해 프롬프트를 생성, 정제, 실험 및 배포할 수 있습니다. 폴더와 버전을 활용하여 프롬프트를 정리하고, 도구 및 컨텍스트를 연결하여 실제 사례로 실험해 보며, 맞춤형 로직을 기반으로 배포할 수 있습니다.

|

||||

|

||||

[**모델 구성**](https://www.getmaxim.ai/docs/introduction/quickstart/setting-up-workspace#add-model-api-keys)을 통해 여러 모델을 손쉽게 실험하고, 프롬프트 플레이그라운드 상단 드롭다운에서 원하는 모델을 선택하세요.

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/maxim_playground.png'> </img>

|

||||

</Tab>

|

||||

<Tab title="프롬프트 버전">

|

||||

팀이 AI 애플리케이션을 개발할 때, 실험의 중요한 부분은 프롬프트 구조를 반복적으로 개선하는 것입니다. 효과적으로 협업하고 변경 사항을 명확히 정리할 수 있도록 Maxim은 프롬프트 버전 관리와 버전 간 비교 실행을 지원합니다.

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/maxim_versions.png'> </img>

|

||||

</Tab>

|

||||

<Tab title="프롬프트 비교">

|

||||

AI 애플리케이션을 발전시켜 나가면서 프롬프트를 반복 개선하기 위해서는 모델, 프롬프트 구조 등 다양한 요소로 실험이 필요합니다. 버전 간 비교 및 변화에 대한 정보에 기반한 결정을 위해, 비교 플레이그라운드는 결과를 나란히 볼 수 있게 해줍니다.

|

||||

|

||||

## **프롬프트 비교를 왜 사용해야 하나요?**

|

||||

|

||||

프롬프트 비교는 여러 개의 단일 프롬프트를 하나의 뷰에서 볼 수 있도록 하여 다양한 워크플로에 streamlined 접근을 제공합니다:

|

||||

|

||||

1. **모델 비교**: 동일한 프롬프트에서 서로 다른 모델의 성능을 평가합니다.

|

||||

2. **프롬프트 최적화**: 여러 버전의 프롬프트를 비교하여 가장 효과적인 구성을 식별합니다.

|

||||

3. **교차 모델 일관성**: 동일한 프롬프트에 대해 여러 모델에서 일관된 출력을 보장합니다.

|

||||

4. **성능 벤치마킹**: 다양한 모델과 프롬프트에 대해 지연 시간, 비용, 토큰 수 등의 지표를 분석합니다.

|

||||

</Tab>

|

||||

</Tabs>

|

||||

|

||||

### 관찰 가능성 & 평가

|

||||

|

||||

Maxim AI는 CrewAI 에이전트에 대한 포괄적인 관찰 가능성과 평가 기능을 제공하여, 각 실행 과정에서 무슨 일이 일어나고 있는지 정확히 파악할 수 있도록 지원합니다.

|

||||

|

||||

<Tabs>

|

||||

<Tab title="Agent Tracing">

|

||||

에이전트의 전체 라이프사이클(도구 호출, 에이전트 궤적, 결정 플로우 등)을 손쉽게 추적할 수 있습니다.

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/maxim_agent_tracking.png'> </img>

|

||||

</Tab>

|

||||

<Tab title="Analytics + Evals">

|

||||

전체 트레이스 또는 개별 노드에 대해 상세 평가를 실행할 수 있으며, 다음 기능을 지원합니다:

|

||||

|

||||

- 다중 단계 상호작용 및 세분화된 트레이스 분석

|

||||

- 세션 수준 평가

|

||||

- 실제 환경 시뮬레이션 테스트

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/maxim_trace_eval.png'> </img>

|

||||

|

||||

<CardGroup cols={3}>

|

||||

<Card title="로그 자동 평가" icon="e" href="https://www.getmaxim.ai/docs/observe/how-to/evaluate-logs/auto-evaluation">

|

||||

<p>

|

||||

필터 및 샘플링을 기준으로 UI에서 캡처된 로그를 자동으로 평가할 수 있습니다.

|

||||

</p>

|

||||

</Card>

|

||||

<Card title="로그 수동 평가" icon="hand" href="https://www.getmaxim.ai/docs/observe/how-to/evaluate-logs/human-evaluation">

|

||||

<p>

|

||||

로그의 품질을 평가하고, 사람의 평가 또는 등급을 이용해 로그를 검토할 수 있습니다.

|

||||

</p>

|

||||

</Card>

|

||||

<Card title="노드 수준 평가" icon="road" href="https://www.getmaxim.ai/docs/observe/how-to/evaluate-logs/node-level-evaluation">

|

||||

<p>

|

||||

트레이스 또는 로그의 모든 컴포넌트를 평가하여 에이전트의 행동에 대한 통찰을 얻을 수 있습니다.

|

||||

</p>

|

||||

</Card>

|

||||

</CardGroup>

|

||||

---

|

||||

</Tab>

|

||||

<Tab title="Alerting">

|

||||

**오류**, **비용, 토큰 사용량, 사용자 피드백, 지연 시간**에 임계값을 설정하고, Slack 또는 PagerDuty를 통해 실시간 알림을 받아보세요.

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/maxim_alerts_1.png'> </img>

|

||||

</Tab>

|

||||

<Tab title="Dashboards">

|

||||

시간 경과에 따른 트레이스, 사용량 측정지표, 지연 시간 및 오류율을 손쉽게 시각화할 수 있습니다.

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/maxim_dashboard_1.png'> </img>

|

||||

</Tab>

|

||||

</Tabs>

|

||||

|

||||

## 시작하기

|

||||

|

||||

### 사전 준비 사항

|

||||

|

||||

- Python 버전 \>=3.10

|

||||

- Maxim 계정 ([여기에서 가입](https://getmaxim.ai/))

|

||||

- Maxim API 키 생성

|

||||

- CrewAI 프로젝트

|

||||

|

||||

### 설치

|

||||

|

||||

Maxim SDK를 pip을 통해 설치하세요:

|

||||

|

||||

```python

|

||||

pip install maxim-py

|

||||

```

|

||||

|

||||

또는 `requirements.txt`에 추가하세요:

|

||||

|

||||

```

|

||||

maxim-py

|

||||

```

|

||||

|

||||

### 기본 설정

|

||||

|

||||

### 1. 환경 변수 설정

|

||||

|

||||

```python

|

||||

### Environment Variables Setup

|

||||

|

||||

# Create a `.env` file in your project root:

|

||||

|

||||

# Maxim API Configuration

|

||||

MAXIM_API_KEY=your_api_key_here

|

||||

MAXIM_LOG_REPO_ID=your_repo_id_here

|

||||

```

|

||||

|

||||

### 2. 필수 패키지 임포트하기

|

||||

|

||||

```python

|

||||

from crewai import Agent, Task, Crew, Process

|

||||

from maxim import Maxim

|

||||

from maxim.logger.crewai import instrument_crewai

|

||||

```

|

||||

|

||||

### 3. API 키로 Maxim 초기화하기

|

||||

|

||||

```python {8}

|

||||

# Instrument CrewAI with just one line

|

||||

instrument_crewai(Maxim().logger())

|

||||

```

|

||||

|

||||

### 4. 일반적으로 CrewAI 애플리케이션 생성 및 실행하기

|

||||

|

||||

```python

|

||||

# Create your agent

|

||||

researcher = Agent(

|

||||

role='Senior Research Analyst',

|

||||

goal='Uncover cutting-edge developments in AI',

|

||||

backstory="You are an expert researcher at a tech think tank...",

|

||||

verbose=True,

|

||||

llm=llm

|

||||

)

|

||||

|

||||

# Define the task

|

||||

research_task = Task(

|

||||

description="Research the latest AI advancements...",

|

||||

expected_output="",

|

||||

agent=researcher

|

||||

)

|

||||

|

||||

# Configure and run the crew

|

||||

crew = Crew(

|

||||

agents=[researcher],

|

||||

tasks=[research_task],

|

||||

verbose=True

|

||||

)

|

||||

|

||||

try:

|

||||

result = crew.kickoff()

|

||||

finally:

|

||||

maxim.cleanup() # Ensure cleanup happens even if errors occur

|

||||

```

|

||||

|

||||

이제 끝입니다! 모든 CrewAI 에이전트 상호작용이 Maxim 대시보드에 기록되고 확인할 수 있습니다.

|

||||

|

||||

간단한 참고를 위해 이 Google Colab Notebook을 확인하세요 - [Notebook](https://colab.research.google.com/drive/1ZKIZWsmgQQ46n8TH9zLsT1negKkJA6K8?usp=sharing)

|

||||

|

||||

## 트레이스 보기

|

||||

|

||||

CrewAI 애플리케이션을 실행한 후:

|

||||

|

||||

1. [Maxim 대시보드](https://app.getmaxim.ai/login)에 로그인하세요.

|

||||

2. 리포지토리로 이동하세요.

|

||||

3. 다음을 포함한 에이전트 트레이스를 상세하게 확인할 수 있습니다:

|

||||

- 에이전트 대화 내역

|

||||

- 도구 사용 패턴

|

||||

- 성능 지표

|

||||

- 비용 분석

|

||||

|

||||

<img src='https://raw.githubusercontent.com/akmadan/crewAI/docs_maxim_observability/docs/images/crewai_traces.gif'> </img>

|

||||

|

||||

## 문제 해결

|

||||

|

||||

### 흔한 문제

|

||||

|

||||

- **추적(trace)가 나타나지 않음**: API 키와 저장소 ID가 올바른지 확인하세요.

|

||||

- crew를 실행하기 **_전에_** 반드시 **`instrument_crewai()`를 호출**했는지 확인하세요. 이 함수가 로깅 훅(logging hook)을 올바르게 초기화합니다.

|

||||

- 내부 오류를 드러내기 위해 `instrument_crewai()` 호출 시 `debug=True`로 설정하세요:

|

||||

|

||||

```python

|

||||

instrument_crewai(logger, debug=True)

|

||||

```

|

||||

- 에이전트에서 상세 로그를 캡처하기 위해 `verbose=True`로 설정하세요:

|

||||

|

||||

```python

|

||||

agent = CrewAgent(..., verbose=True)

|

||||

```

|

||||

- `instrument_crewai()`가 에이전트를 생성하거나 실행하기 **전에** 호출되는지 다시 한 번 확인하세요. 너무 당연해 보일 수 있지만, 자주 발생하는 실수입니다.

|

||||

|

||||

## 리소스

|

||||

|

||||

<CardGroup cols="3">

|

||||

<Card title="CrewAI Docs" icon="book" href="https://docs.crewai.com/">

|

||||

공식 CrewAI 문서

|

||||

</Card>

|

||||

<Card title="Maxim Docs" icon="book" href="https://getmaxim.ai/docs">

|

||||

공식 Maxim 문서

|

||||

</Card>

|

||||

<Card title="Maxim Github" icon="github" href="https://github.com/maximhq">

|

||||

Maxim Github

|

||||

</Card>

|

||||

</CardGroup>

|

||||

205

docs/ko/observability/mlflow.mdx

Normal file

205

docs/ko/observability/mlflow.mdx

Normal file

@@ -0,0 +1,205 @@

|

||||

---

|

||||

title: MLflow 통합

|

||||

description: MLflow를 사용하여 에이전트 모니터링을 빠르게 시작하세요.

|

||||

icon: bars-staggered

|

||||

---

|

||||

|

||||

# MLflow 개요

|

||||

|

||||

[MLflow](https://mlflow.org/)는 머신러닝 실무자와 팀이 머신러닝 프로세스의 복잡성을 관리할 수 있도록 돕는 오픈소스 플랫폼입니다.

|

||||

|

||||

MLflow는 귀하의 생성형 AI 애플리케이션에서 서비스 실행에 대한 상세 정보를 캡처하여 LLM 가시성을 향상시키는 트레이싱 기능을 제공합니다.

|

||||

트레이싱은 요청의 각 중간 단계에 관련된 입력값, 출력값, 메타데이터를 기록하는 방법을 제공하여, 버그 및 예기치 않은 동작의 원인을 쉽게 찾아낼 수 있게 합니다.

|

||||

|

||||

|

||||

|

||||

### 기능

|

||||

|

||||

- **트레이싱 대시보드**: crewAI 에이전트의 활동을 입력값, 출력값, 스팬의 메타데이터와 함께 자세한 대시보드로 모니터링할 수 있습니다.

|

||||

- **자동 트레이싱**: 완전 자동화된 crewAI 통합 기능으로, `mlflow.crewai.autolog()`를 실행하여 활성화할 수 있습니다.

|

||||

- **약간의 노력만으로 수동 추적 계측**: 데코레이터, 함수 래퍼, 컨텍스트 매니저 등 MLflow의 고수준 fluent API를 통해 추적 계측을 커스터마이즈할 수 있습니다.

|

||||

- **OpenTelemetry 호환성**: MLflow Tracing은 OpenTelemetry Collector로 트레이스를 내보내는 것을 지원하며, 이를 통해 Jaeger, Zipkin, AWS X-Ray 등 다양한 백엔드로 트레이스를 내보낼 수 있습니다.

|

||||

- **에이전트 패키징 및 배포**: crewAI 에이전트를 다양한 배포 대상으로 추론 서버에 패키징 및 배포할 수 있습니다.

|

||||

- **LLM을 안전하게 호스팅**: 여러 공급자의 LLM을 MFflow 게이트웨이를 통해 하나의 통합 엔드포인트에서 호스팅할 수 있습니다.

|

||||

- **평가**: 편리한 API `mlflow.evaluate()`를 사용하여 다양한 지표로 crewAI 에이전트를 평가할 수 있습니다.

|

||||

|

||||

## 설치 안내

|

||||

|

||||

<Steps>

|

||||

<Step title="MLflow 패키지 설치">

|

||||

```shell

|

||||

# crewAI 연동은 mlflow>=2.19.0 에서 사용할 수 있습니다.

|

||||

pip install mlflow

|

||||

```

|

||||

</Step>

|

||||

<Step title="MLflow 추적 서버 시작">

|

||||

```shell

|

||||

# 이 과정은 선택 사항이지만, MLflow 추적 서버를 사용하면 더 나은 시각화와 더 많은 기능을 사용할 수 있습니다.

|

||||

mlflow server

|

||||

```

|

||||

</Step>

|

||||

<Step title="애플리케이션에서 MLflow 초기화">

|

||||

다음 두 줄을 애플리케이션 코드에 추가하세요:

|

||||

|

||||

```python

|

||||

import mlflow

|

||||

|

||||

mlflow.crewai.autolog()

|

||||

|

||||

# 선택 사항: 추적 서버를 사용하는 경우 tracking URI와 experiment 이름을 설정할 수 있습니다.

|

||||

mlflow.set_tracking_uri("http://localhost:5000")

|

||||

mlflow.set_experiment("CrewAI")

|

||||

```

|

||||

|

||||

CrewAI Agents 추적 예시 사용법:

|

||||

|

||||

```python

|

||||

from crewai import Agent, Crew, Task

|

||||

from crewai.knowledge.source.string_knowledge_source import StringKnowledgeSource

|

||||

from crewai_tools import SerperDevTool, WebsiteSearchTool

|

||||

|

||||

from textwrap import dedent

|

||||

|

||||

content = "Users name is John. He is 30 years old and lives in San Francisco."

|

||||

string_source = StringKnowledgeSource(

|

||||

content=content, metadata={"preference": "personal"}

|

||||

)

|

||||

|

||||

search_tool = WebsiteSearchTool()

|

||||

|

||||

|

||||

class TripAgents:

|

||||

def city_selection_agent(self):

|

||||

return Agent(

|

||||

role="City Selection Expert",

|

||||

goal="Select the best city based on weather, season, and prices",

|

||||

backstory="An expert in analyzing travel data to pick ideal destinations",

|

||||

tools=[

|

||||

search_tool,

|

||||

],

|

||||

verbose=True,

|

||||

)

|

||||

|

||||

def local_expert(self):

|

||||

return Agent(

|

||||

role="Local Expert at this city",

|

||||

goal="Provide the BEST insights about the selected city",

|

||||

backstory="""A knowledgeable local guide with extensive information

|

||||

about the city, it's attractions and customs""",

|

||||

tools=[search_tool],

|

||||

verbose=True,

|

||||

)

|

||||

|

||||

|

||||

class TripTasks:

|

||||

def identify_task(self, agent, origin, cities, interests, range):

|

||||

return Task(

|

||||

description=dedent(

|

||||

f"""

|

||||

Analyze and select the best city for the trip based

|

||||

on specific criteria such as weather patterns, seasonal

|

||||

events, and travel costs. This task involves comparing

|

||||

multiple cities, considering factors like current weather

|

||||

conditions, upcoming cultural or seasonal events, and

|

||||

overall travel expenses.

|

||||

Your final answer must be a detailed

|

||||

report on the chosen city, and everything you found out

|

||||

about it, including the actual flight costs, weather

|

||||

forecast and attractions.

|

||||

|

||||

Traveling from: {origin}

|

||||

City Options: {cities}

|

||||

Trip Date: {range}

|

||||

Traveler Interests: {interests}

|

||||

"""

|

||||

),

|

||||

agent=agent,

|

||||

expected_output="Detailed report on the chosen city including flight costs, weather forecast, and attractions",

|

||||

)

|

||||

|

||||

def gather_task(self, agent, origin, interests, range):

|

||||

return Task(

|

||||

description=dedent(

|

||||

f"""

|

||||

As a local expert on this city you must compile an

|

||||

in-depth guide for someone traveling there and wanting

|

||||

to have THE BEST trip ever!

|

||||

Gather information about key attractions, local customs,

|

||||

special events, and daily activity recommendations.

|

||||

Find the best spots to go to, the kind of place only a

|

||||

local would know.

|

||||

This guide should provide a thorough overview of what

|

||||

the city has to offer, including hidden gems, cultural

|

||||

hotspots, must-visit landmarks, weather forecasts, and

|

||||

high level costs.

|

||||

The final answer must be a comprehensive city guide,

|

||||

rich in cultural insights and practical tips,

|

||||

tailored to enhance the travel experience.

|

||||

|

||||

Trip Date: {range}

|

||||

Traveling from: {origin}

|

||||

Traveler Interests: {interests}

|

||||

"""

|

||||

),

|

||||

agent=agent,

|

||||

expected_output="Comprehensive city guide including hidden gems, cultural hotspots, and practical travel tips",

|

||||

)

|

||||

|

||||

|

||||

class TripCrew:

|

||||

def __init__(self, origin, cities, date_range, interests):

|

||||

self.cities = cities

|

||||

self.origin = origin

|

||||

self.interests = interests

|

||||

self.date_range = date_range

|

||||

|

||||

def run(self):

|

||||

agents = TripAgents()

|

||||

tasks = TripTasks()

|

||||

|

||||

city_selector_agent = agents.city_selection_agent()

|

||||

local_expert_agent = agents.local_expert()

|

||||

|

||||

identify_task = tasks.identify_task(

|

||||

city_selector_agent,

|

||||

self.origin,

|

||||

self.cities,

|

||||

self.interests,

|

||||

self.date_range,

|

||||

)

|

||||

gather_task = tasks.gather_task(

|

||||

local_expert_agent, self.origin, self.interests, self.date_range

|

||||

)

|

||||

|

||||

crew = Crew(

|

||||

agents=[city_selector_agent, local_expert_agent],

|

||||

tasks=[identify_task, gather_task],

|

||||

verbose=True,

|

||||

memory=True,

|

||||

knowledge={

|

||||

"sources": [string_source],

|

||||

"metadata": {"preference": "personal"},

|

||||

},

|

||||

)

|

||||

|

||||

result = crew.kickoff()

|

||||

return result

|

||||

|

||||

|

||||

trip_crew = TripCrew("California", "Tokyo", "Dec 12 - Dec 20", "sports")

|

||||

result = trip_crew.run()

|

||||

|

||||

print(result)

|

||||

```

|

||||

더 많은 설정 및 사용 예시는 [MLflow Tracing 문서](https://mlflow.org/docs/latest/llms/tracing/index.html)를 참고하세요.

|

||||

</Step>

|

||||

<Step title="에이전트 활동 시각화">

|

||||

이제 crewAI agents의 추적 정보가 MLflow에서 캡처됩니다.

|

||||

MLflow 추적 서버에 접속하여 추적 내역을 확인하고 에이전트의 인사이트를 얻으세요.

|

||||

|

||||

브라우저에서 `127.0.0.1:5000`을 열어 MLflow 추적 서버에 접속하세요.

|

||||

<Frame caption="MLflow 추적 대시보드">

|

||||

<img src="/images/mlflow1.png" alt="MLflow tracing example with crewai" />

|

||||

</Frame>

|

||||

</Step>

|

||||

</Steps>

|

||||

129

docs/ko/observability/neatlogs.mdx

Normal file

129

docs/ko/observability/neatlogs.mdx

Normal file

@@ -0,0 +1,129 @@

|

||||

---

|

||||

title: Neatlogs 통합

|

||||

description: CrewAI agent 실행을 이해하고, 디버그하며, 공유하기

|

||||

icon: magnifying-glass-chart

|

||||

---

|

||||

|

||||

# 소개

|

||||

|

||||

Neatlogs는 **에이전트가 무엇을 했는지**, **이유는 무엇인지**, 그리고 **공유하는 방법**을 확인할 수 있도록 도와줍니다.

|

||||

|

||||

모든 단계를 캡처합니다: 생각, 도구 호출, 응답, 평가 등. 원시 로그는 없습니다. 명확하고 구조화된 추적만 제공합니다. 디버깅과 협업에 탁월합니다.

|

||||

|

||||

## 왜 Neatlogs를 사용해야 하나요?

|

||||

|

||||

CrewAI 에이전트는 여러 도구와 추론 단계를 사용합니다. 문제가 발생했을 때, 단순한 오류만으로는 충분하지 않습니다 — 맥락이 필요합니다.

|

||||

|

||||

Neatlogs를 사용하면 다음과 같은 이점이 있습니다:

|

||||

|

||||

- 전체 의사 결정 경로를 따라갈 수 있습니다

|

||||

- 단계마다 직접 피드백을 남길 수 있습니다

|

||||

- AI 어시스턴트와 함께 트레이스에 대해 채팅할 수 있습니다

|

||||

- 실행 결과를 공개적으로 공유해 피드백을 받을 수 있습니다

|

||||

- 인사이트를 업무로 전환할 수 있습니다

|

||||

|

||||

모두 한 곳에서 가능합니다.

|

||||

|

||||

트레이스를 손쉽게 관리하세요

|

||||

|

||||

|

||||

|

||||

|

||||

CrewAI 트레이스를 보기 위한 최고의 UX. 원하는 곳 어디든 댓글을 남기세요. AI를 활용해 디버깅할 수 있습니다.

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

## 핵심 기능

|

||||

|

||||

- **Trace Viewer**: 사고, 도구, 결정을 순서대로 추적

|

||||

- **인라인 댓글**: 모든 trace 단계에서 팀원을 태그

|

||||

- **피드백 및 평가**: 출력물을 올바름 또는 틀림으로 표시

|

||||

- **오류 하이라이팅**: API/도구 실패 자동 감지

|

||||

- **작업 전환**: 댓글을 할당된 작업으로 변환

|

||||

- **Ask the Trace (AI)**: Neatlogs AI 봇과 trace에서 채팅

|

||||

- **공개 공유**: trace 링크를 커뮤니티에 게시

|

||||

|

||||

## CrewAI로 빠른 설정하기

|

||||

|

||||

<Steps>

|

||||

<Step title="회원가입 및 API 키 발급">

|

||||

[neatlogs.com](https://neatlogs.com/?utm_source=crewAI-docs)에 방문하여 프로젝트를 생성하고, API 키를 복사하세요.

|

||||

</Step>

|

||||

<Step title="SDK 설치">

|

||||

```bash

|

||||

pip install neatlogs

|

||||

```

|

||||

(최신 버전 0.8.0, Python 3.8+; MIT 라이선스)

|

||||

</Step>

|

||||

<Step title="Neatlogs 초기화">

|

||||

Crew 에이전트를 시작하기 전에 다음을 추가하세요:

|

||||

|

||||

```python

|

||||

import neatlogs

|

||||

neatlogs.init("YOUR_PROJECT_API_KEY")

|

||||

```

|

||||

|

||||

에이전트는 평소와 같이 실행됩니다. Neatlogs가 모든 것을 자동으로 캡처합니다.

|

||||

|

||||

</Step>

|

||||

</Steps>

|

||||

|

||||

## 내부 구조

|

||||

|

||||

GitHub에 따르면, Neatlogs는:

|

||||

|

||||

- 생각, 도구 호출, 응답, 오류, 그리고 토큰 통계를 캡처합니다

|

||||

- AI 기반 작업 생성과 견고한 평가 워크플로우를 지원합니다

|

||||

|

||||

이 모든 것이 단 두 줄의 코드로 가능합니다.

|

||||

|

||||

## 작동하는 모습을 살펴보기

|

||||

|

||||

### 🔍 전체 데모 (4 분)

|

||||

|

||||

<iframe

|

||||

width="100%"

|

||||

height="315"

|

||||

src="https://www.youtube.com/embed/8KDme9T2I7Q?si=b8oHteaBwFNs_Duk"

|

||||

title="YouTube video player"

|

||||

frameBorder="0"

|

||||

allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture"

|

||||

allowFullScreen

|

||||

></iframe>

|

||||

|

||||

### ⚙️ CrewAI 통합 (30초)

|

||||

|

||||

<iframe

|

||||

className="w-full aspect-video rounded-xl"

|

||||

src="https://www.loom.com/embed/9c78b552af43452bb3e4783cb8d91230?sid=e9d7d370-a91a-49b0-809e-2f375d9e801d"

|

||||

title="Loom video player"

|

||||

frameBorder="0"

|

||||

allowFullScreen

|

||||

></iframe>

|

||||

|

||||

## 링크 & 지원

|

||||

|

||||

- 📘 [Neatlogs 문서](https://docs.neatlogs.com/)

|

||||

- 🔐 [대시보드 & API 키](https://app.neatlogs.com/)

|

||||

- 🐦 [트위터 팔로우](https://twitter.com/neatlogs)

|

||||

- 📧 문의: hello@neatlogs.com

|

||||

- 🛠 [GitHub SDK](https://github.com/NeatLogs/neatlogs)

|

||||

|

||||

## TL;DR

|

||||

|

||||

아래와 같이:

|

||||

|

||||

```bash

|

||||

pip install neatlogs

|

||||

|

||||

import neatlogs

|

||||

neatlogs.init("YOUR_API_KEY")

|

||||

|

||||

You can now capture, understand, share, and act on your CrewAI agent runs in seconds.

|

||||

No setup overhead. Full trace transparency. Full team collaboration.

|

||||

```

|

||||

|

||||

이제 몇 초 만에 CrewAI agent 실행을 캡처, 이해, 공유하고 바로 조치할 수 있습니다.

|

||||

별도의 설정이 필요하지 않습니다. 완전한 트레이스 투명성. 전체 팀 협업 지원.

|

||||

180

docs/ko/observability/openlit.mdx

Normal file

180

docs/ko/observability/openlit.mdx

Normal file

@@ -0,0 +1,180 @@

|

||||

---

|

||||

title: OpenLIT 통합

|

||||

description: OpenTelemetry와 함께 단 한 줄의 코드로 에이전트를 신속하게 모니터링을 시작하세요.

|

||||

icon: magnifying-glass-chart

|

||||

---

|

||||

|

||||

# OpenLIT 개요

|

||||

|

||||

[OpenLIT](https://github.com/openlit/openlit?src=crewai-docs)은 오픈 소스 도구로, 단 **한** 줄의 코드만으로 AI 에이전트, LLM, VectorDB, GPU의 성능을 간편하게 모니터링할 수 있습니다.

|

||||

|

||||

OpenTelemetry-기반의 트레이싱 및 메트릭을 제공하여 비용, 지연 시간, 상호작용, 작업 시퀀스와 같은 주요 파라미터를 추적할 수 있습니다.

|

||||

이 설정을 통해 하이퍼파라미터를 추적하고 성능 문제를 모니터링하며, 시간이 지남에 따라 에이전트를 개선하고 미세 조정할 방법을 찾을 수 있습니다.

|

||||

|

||||

<Frame caption="OpenLIT 대시보드">

|

||||

<img src="/images/openlit1.png" alt="비용 및 토큰을 포함한 에이전트 사용 개요" />

|

||||

<img src="/images/openlit2.png" alt="에이전트 otel 트레이스 및 메트릭 개요" />

|

||||

<img src="/images/openlit3.png" alt="에이전트 트레이스 상세 개요" />

|

||||

</Frame>

|

||||

|

||||

### 기능

|

||||

|

||||

- **분석 대시보드**: 에이전트의 상태와 성능을 모니터링할 수 있는 대시보드를 통해 지표, 비용, 사용자 상호작용을 자세히 추적할 수 있습니다.

|

||||

- **OpenTelemetry-네이티브 가시성 SDK**: Grafana, DataDog 등 기존 가시성 도구로 추적 및 지표를 전송할 수 있는 벤더 중립적 SDK를 제공합니다.

|

||||

- **커스텀 및 파인튜닝 모델 비용 추적**: 정확한 예산 책정을 위해 커스텀 가격 파일을 사용하여 특정 모델의 비용 추정치를 맞춤화할 수 있습니다.

|

||||

- **예외 모니터링 대시보드**: 모니터링 대시보드를 통해 일반적인 예외 및 오류를 추적하여 문제를 신속하게 찾아내고 해결할 수 있습니다.

|

||||

- **컴플라이언스 및 보안**: 욕설 및 PII 유출과 같은 잠재적인 위협을 탐지합니다.

|

||||

- **프롬프트 인젝션 탐지**: 잠재적인 코드 인젝션 및 비밀 유출을 식별합니다.

|

||||

- **API 키 및 비밀 관리**: LLM API 키와 비밀을 중앙에서 안전하게 관리하여 안전하지 않은 관행을 방지합니다.

|

||||

- **프롬프트 관리**: PromptHub을 사용하여 에이전트 프롬프트를 관리 및 버전 관리하고, 모든 에이전트에서 일관되고 쉽게 접근할 수 있습니다.

|

||||

- **모델 플레이그라운드**: 배포 전에 CrewAI 에이전트에 사용할 다양한 모델을 테스트하고 비교할 수 있습니다.

|

||||

|

||||

## 설치 안내

|

||||

|

||||

<Steps>

|

||||

<Step title="OpenLIT 배포">

|

||||

<Steps>

|

||||

<Step title="OpenLIT 저장소 Git Clone">

|

||||

```shell

|

||||

git clone git@github.com:openlit/openlit.git

|

||||

```

|

||||

</Step>

|

||||

<Step title="Docker Compose 시작">

|

||||

[OpenLIT 저장소](https://github.com/openlit/openlit)의 루트 디렉토리에서 아래 명령어를 실행하세요:

|

||||

```shell

|

||||

docker compose up -d

|

||||

```

|

||||

</Step>

|

||||

</Steps>

|

||||

</Step>

|

||||

<Step title="OpenLIT SDK 설치">

|

||||

```shell

|

||||

pip install openlit

|

||||

```

|

||||

</Step>

|

||||

<Step title="애플리케이션에서 OpenLIT 초기화">

|

||||

아래 두 줄을 애플리케이션 코드에 추가하세요:

|

||||

<Tabs>

|

||||

<Tab title="함수 인자 사용 설정">

|

||||

```python

|

||||

import openlit

|

||||

openlit.init(otlp_endpoint="http://127.0.0.1:4318")

|

||||

```

|

||||

|

||||

CrewAI Agent 모니터링 예제:

|

||||

|

||||

```python

|

||||

from crewai import Agent, Task, Crew, Process

|

||||

import openlit

|

||||

|

||||

openlit.init(disable_metrics=True)

|

||||

# 에이전트 정의

|

||||

researcher = Agent(

|

||||

role="Researcher",

|

||||

goal="Conduct thorough research and analysis on AI and AI agents",

|

||||

backstory="You're an expert researcher, specialized in technology, software engineering, AI, and startups. You work as a freelancer and are currently researching for a new client.",

|

||||

allow_delegation=False,

|

||||

llm='command-r'

|

||||

)

|

||||

|

||||

|

||||

# 작업 정의

|

||||

task = Task(

|

||||

description="Generate a list of 5 interesting ideas for an article, then write one captivating paragraph for each idea that showcases the potential of a full article on this topic. Return the list of ideas with their paragraphs and your notes.",

|

||||

expected_output="5 bullet points, each with a paragraph and accompanying notes.",

|

||||

)

|

||||

|

||||

# 매니저 에이전트 정의

|

||||

manager = Agent(

|

||||

role="Project Manager",

|

||||

goal="Efficiently manage the crew and ensure high-quality task completion",

|

||||

backstory="You're an experienced project manager, skilled in overseeing complex projects and guiding teams to success. Your role is to coordinate the efforts of the crew members, ensuring that each task is completed on time and to the highest standard.",

|

||||

allow_delegation=True,

|

||||

llm='command-r'

|

||||

)

|

||||

|

||||

# 커스텀 매니저로 crew 인스턴스화

|

||||

crew = Crew(

|

||||

agents=[researcher],

|

||||

tasks=[task],

|

||||

manager_agent=manager,

|

||||

process=Process.hierarchical,

|

||||

)

|

||||

|

||||

# crew 작업 시작

|

||||

result = crew.kickoff()

|

||||

|

||||

print(result)

|

||||

```

|

||||

</Tab>

|

||||

<Tab title="환경 변수 사용 설정">

|

||||

|

||||

아래 두 줄을 애플리케이션 코드에 추가하세요:

|

||||

```python

|

||||

import openlit

|

||||

|

||||

openlit.init()

|

||||

```

|

||||

|

||||

OTEL export endpoint를 설정하려면 다음 명령어를 실행하세요:

|

||||

```shell

|

||||

export OTEL_EXPORTER_OTLP_ENDPOINT = "http://127.0.0.1:4318"

|

||||

```

|

||||

|

||||

CrewAI Async Agent 모니터링 예제:

|

||||

|

||||

```python

|

||||

import asyncio

|

||||

from crewai import Crew, Agent, Task

|

||||

import openlit

|

||||

|

||||

openlit.init(otlp_endpoint="http://127.0.0.1:4318")

|

||||

|

||||

# 코드 실행이 활성화된 에이전트 생성

|

||||

coding_agent = Agent(

|

||||

role="Python Data Analyst",

|

||||

goal="Analyze data and provide insights using Python",

|

||||

backstory="You are an experienced data analyst with strong Python skills.",

|

||||

allow_code_execution=True,

|

||||

llm="command-r"

|

||||

)

|

||||

|

||||

# 코드 실행이 필요한 작업 생성

|

||||

data_analysis_task = Task(

|

||||

description="Analyze the given dataset and calculate the average age of participants. Ages: {ages}",

|

||||

agent=coding_agent,

|

||||

expected_output="5 bullet points, each with a paragraph and accompanying notes.",

|

||||

)

|

||||

|

||||

# crew 생성 후 작업 추가

|

||||

analysis_crew = Crew(

|

||||

agents=[coding_agent],

|

||||

tasks=[data_analysis_task]

|

||||

)

|

||||

|

||||

# crew를 비동기적으로 kickoff 하는 함수

|

||||

async def async_crew_execution():

|

||||

result = await analysis_crew.kickoff_async(inputs={"ages": [25, 30, 35, 40, 45]})

|

||||

print("Crew Result:", result)

|

||||

|

||||

# 비동기 함수 실행

|

||||

asyncio.run(async_crew_execution())

|

||||

```

|

||||

</Tab>

|

||||

</Tabs>

|

||||

더 고급 설정 및 사용 사례는 OpenLIT [Python SDK 저장소](https://github.com/openlit/openlit/tree/main/sdk/python)를 참고하세요.

|

||||

</Step>

|

||||

<Step title="시각화 및 분석">

|

||||

이제 에이전트 관찰 데이터가 수집되어 OpenLIT으로 전송되고 있으므로, 다음 단계는 이 데이터를 시각화하고 분석하여 에이전트의 성능, 행동 및 개선이 필요한 영역에 대한 인사이트를 얻는 것입니다.

|

||||

|

||||

브라우저에서 `127.0.0.1:3000`으로 접속하여 바로 시작할 수 있습니다. 기본 자격 증명으로 로그인 가능합니다

|

||||

- **이메일**: `user@openlit.io`

|

||||

- **비밀번호**: `openlituser`

|

||||

|

||||

<Frame caption="OpenLIT 대시보드">

|

||||

<img src="/images/openlit1.png" alt="비용 및 토큰을 포함한 에이전트 사용 개요" />

|

||||

<img src="/images/openlit2.png" alt="에이전트 otel trace 및 메트릭 개요" />

|

||||

</Frame>

|

||||

|

||||

</Step>

|

||||

</Steps>

|

||||

130

docs/ko/observability/opik.mdx

Normal file

130

docs/ko/observability/opik.mdx

Normal file

@@ -0,0 +1,130 @@

|

||||

---

|

||||

title: Opik 통합

|

||||

description: Comet Opik을 사용하여 CrewAI 애플리케이션을 포괄적인 트레이싱, 자동 평가, 프로덕션 준비 대시보드로 디버그, 평가 및 모니터링하는 방법을 알아보세요.

|

||||

icon: meteor

|

||||

---

|

||||

|

||||

# Opik 개요

|

||||

|

||||

[Comet Opik](https://www.comet.com/docs/opik/)을(를) 사용하여, 포괄적인 트레이싱, 자동 평가, 프로덕션 준비가 된 대시보드를 통해 LLM 애플리케이션, RAG 시스템, 에이전트 워크플로우를 디버깅, 평가 및 모니터링할 수 있습니다.

|

||||

|

||||

<Frame caption="Opik 에이전트 대시보드">

|

||||

<img src="/images/opik-crewai-dashboard.png" alt="CrewAI와 함께하는 Opik 에이전트 모니터링 예시" />

|

||||

</Frame>

|

||||

|

||||

Opik은 CrewAI 애플리케이션 개발의 모든 단계에서 포괄적인 지원을 제공합니다:

|

||||

|

||||

- **로그 트레이스 및 스팬**: 개발 및 프로덕션 시스템에서 LLM 호출과 애플리케이션 로직을 자동으로 추적하여 디버깅 및 분석이 가능합니다. 프로젝트 간 응답을 수동 또는 프로그램적으로 주석 달고, 조회하고, 비교할 수 있습니다.

|

||||

- **LLM 애플리케이션 성능 평가**: 사용자 지정 테스트 세트로 평가하고, 내장된 평가 지표를 실행하거나 SDK 또는 UI에서 사용자만의 지표를 정의할 수 있습니다.

|

||||

- **CI/CD 파이프라인 내 테스트**: PyTest 기반의 Opik LLM 단위 테스트로 신뢰할 수 있는 성능 기준선을 설정하세요. 프로덕션에서 연속 모니터링을 위한 온라인 평가도 실행할 수 있습니다.

|

||||