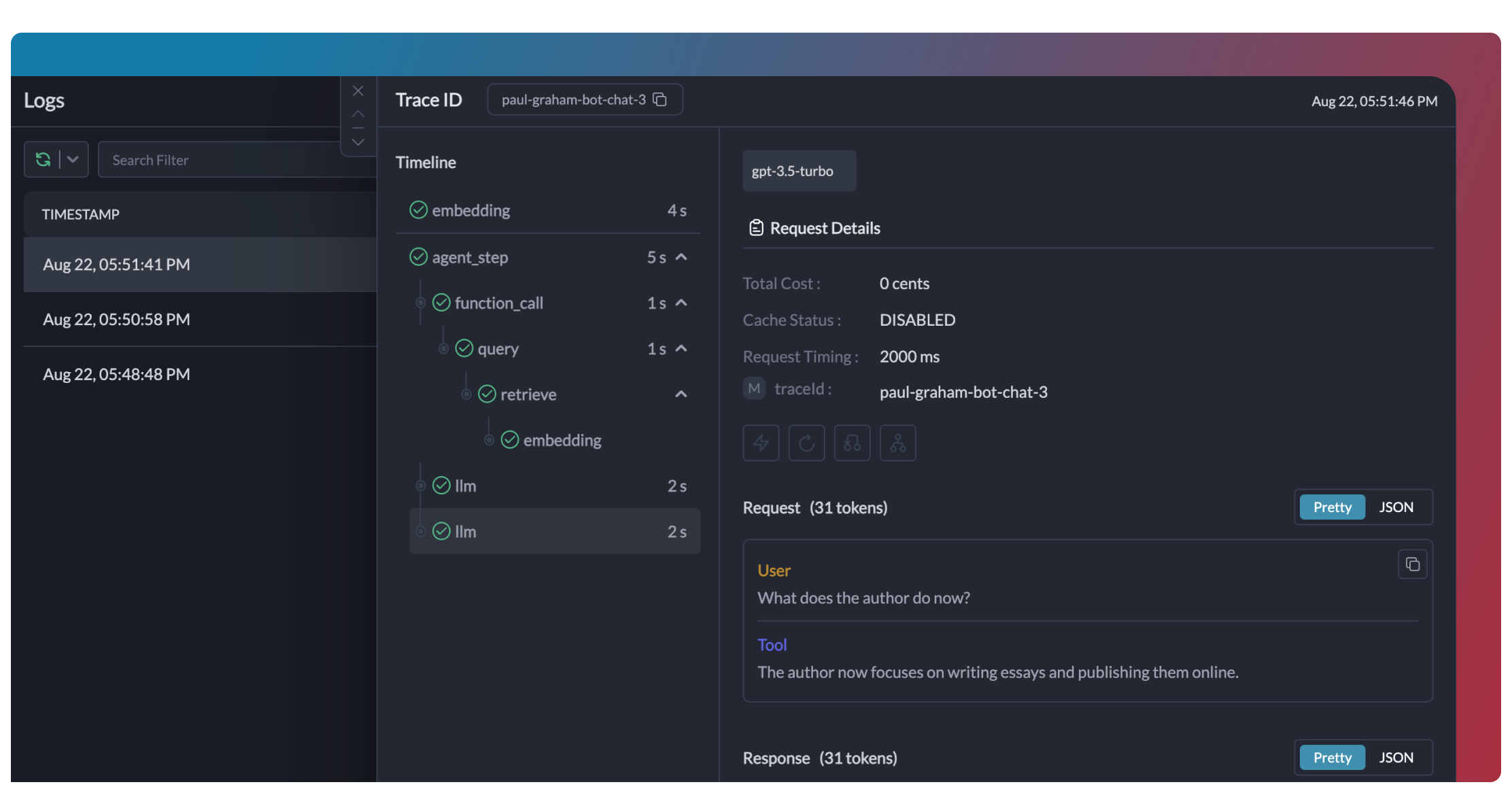

Os traces fornecem uma visão hierárquica da execução do seu crew, mostrando a sequência de chamadas LLM, ativações de ferramentas e transições de estado.

```python

# Adicione trace_id para habilitar o tracing hierárquico no Portkey

portkey_llm = LLM(

model="gpt-4o",

base_url=PORTKEY_GATEWAY_URL,

api_key="dummy",

extra_headers=createHeaders(

api_key="YOUR_PORTKEY_API_KEY",

virtual_key="YOUR_OPENAI_VIRTUAL_KEY",

trace_id="unique-session-id" # Adicione um trace ID único

)

)

```

Os traces fornecem uma visão hierárquica da execução do seu crew, mostrando a sequência de chamadas LLM, ativações de ferramentas e transições de estado.

```python

# Adicione trace_id para habilitar o tracing hierárquico no Portkey

portkey_llm = LLM(

model="gpt-4o",

base_url=PORTKEY_GATEWAY_URL,

api_key="dummy",

extra_headers=createHeaders(

api_key="YOUR_PORTKEY_API_KEY",

virtual_key="YOUR_OPENAI_VIRTUAL_KEY",

trace_id="unique-session-id" # Adicione um trace ID único

)

)

```

Portkey registra cada interação com LLMs, incluindo:

- Payloads completos das requisições e respostas

- Métricas de latência e uso de tokens

- Cálculos de custo

- Chamadas de ferramentas e execuções de funções

Todos os logs podem ser filtrados por metadados, trace IDs, modelos e mais, tornando mais fácil depurar execuções específicas do crew.

Portkey registra cada interação com LLMs, incluindo:

- Payloads completos das requisições e respostas

- Métricas de latência e uso de tokens

- Cálculos de custo

- Chamadas de ferramentas e execuções de funções

Todos os logs podem ser filtrados por metadados, trace IDs, modelos e mais, tornando mais fácil depurar execuções específicas do crew.

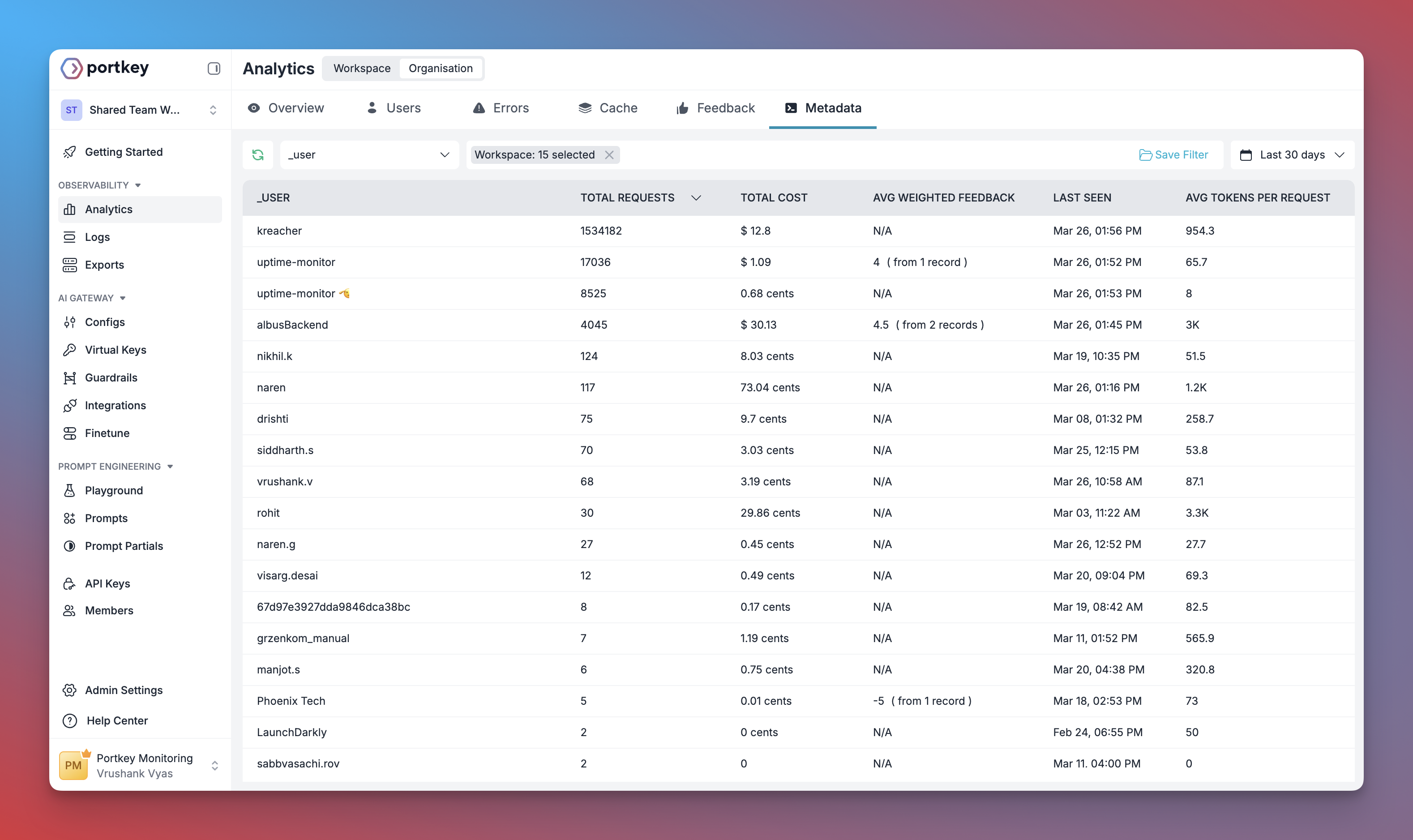

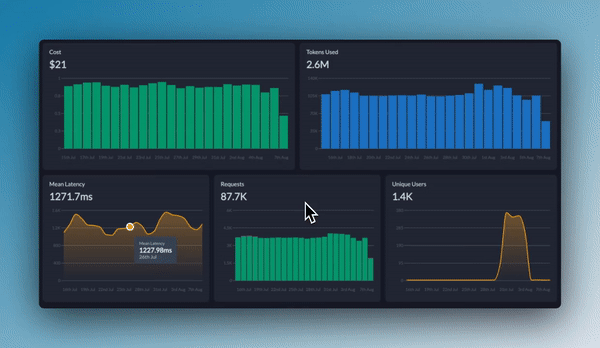

Portkey oferece dashboards integrados que ajudam você a:

- Rastrear custos e uso de tokens em todas as execuções do crew

- Analisar métricas de desempenho, como latência e taxas de sucesso

- Identificar gargalos nos fluxos de trabalho dos agentes

- Comparar diferentes configurações de crew e LLMs

Você pode filtrar e segmentar todas as métricas por metadados personalizados para analisar tipos de crew, grupos de usuários ou casos de uso específicos.

Portkey oferece dashboards integrados que ajudam você a:

- Rastrear custos e uso de tokens em todas as execuções do crew

- Analisar métricas de desempenho, como latência e taxas de sucesso

- Identificar gargalos nos fluxos de trabalho dos agentes

- Comparar diferentes configurações de crew e LLMs

Você pode filtrar e segmentar todas as métricas por metadados personalizados para analisar tipos de crew, grupos de usuários ou casos de uso específicos.

Adicione metadados personalizados à configuração LLM do seu CrewAI para permitir filtragem e segmentação poderosas:

```python

portkey_llm = LLM(

model="gpt-4o",

base_url=PORTKEY_GATEWAY_URL,

api_key="dummy",

extra_headers=createHeaders(

api_key="YOUR_PORTKEY_API_KEY",

virtual_key="YOUR_OPENAI_VIRTUAL_KEY",

metadata={

"crew_type": "research_crew",

"environment": "production",

"_user": "user_123", # Campo especial _user para analytics de usuários

"request_source": "mobile_app"

}

)

)

```

Esses metadados podem ser usados para filtrar logs, traces e métricas no painel do Portkey, permitindo analisar execuções específicas do crew, usuários ou ambientes.

Adicione metadados personalizados à configuração LLM do seu CrewAI para permitir filtragem e segmentação poderosas:

```python

portkey_llm = LLM(

model="gpt-4o",

base_url=PORTKEY_GATEWAY_URL,

api_key="dummy",

extra_headers=createHeaders(

api_key="YOUR_PORTKEY_API_KEY",

virtual_key="YOUR_OPENAI_VIRTUAL_KEY",

metadata={

"crew_type": "research_crew",

"environment": "production",

"_user": "user_123", # Campo especial _user para analytics de usuários

"request_source": "mobile_app"

}

)

)

```

Esses metadados podem ser usados para filtrar logs, traces e métricas no painel do Portkey, permitindo analisar execuções específicas do crew, usuários ou ambientes.

## Introdução

Portkey aprimora o CrewAI com recursos prontos para produção, transformando seus crews de agentes experimentais em sistemas robustos ao fornecer:

- **Observabilidade completa** de cada etapa do agente, uso de ferramentas e interações

- **Confiabilidade incorporada** com fallbacks, tentativas automáticas e balanceamento de carga

- **Rastreamento e otimização de custos** para gerenciar seus gastos com IA

- **Acesso a mais de 200 LLMs** por meio de uma única integração

- **Guardrails** para manter o comportamento dos agentes seguro e em conformidade

- **Prompts versionados** para desempenho consistente dos agentes

### Instalação & Configuração

## Introdução

Portkey aprimora o CrewAI com recursos prontos para produção, transformando seus crews de agentes experimentais em sistemas robustos ao fornecer:

- **Observabilidade completa** de cada etapa do agente, uso de ferramentas e interações

- **Confiabilidade incorporada** com fallbacks, tentativas automáticas e balanceamento de carga

- **Rastreamento e otimização de custos** para gerenciar seus gastos com IA

- **Acesso a mais de 200 LLMs** por meio de uma única integração

- **Guardrails** para manter o comportamento dos agentes seguro e em conformidade

- **Prompts versionados** para desempenho consistente dos agentes

### Instalação & Configuração